在当今高度依赖数字服务的时代,服务器的稳定运行是保障业务连续性的生命线,任何计划外的停机都可能导致巨大的经济损失和品牌声誉损害,为了应对这一挑战,IT领域涌现出多种高可用性架构,“服务器FA/OC”作为一种先进的设计理念与实践框架,正受到越来越多企业的关注,FA/OC并非指某个特定产品,而是对“故障转移”与“自动编排与配置”两种核心技术深度融合的系统化方法的概括,旨在构建一套能够自我感知、自我恢复、自我管理的智能化服务器运行体系。

核心概念解析:FA与OC的协同效应

要理解服务器FA/OC的精髓,首先需要分别剖析其两个核心组成部分:FA和OC。

FA:故障转移

故障转移是高可用性架构的基石,其核心思想是在系统中构建冗余,当主服务器或其上的关键服务因硬件故障、软件错误、网络中断等原因不可用时,系统能够自动、快速地将业务流量切换到预先设定的备用服务器上,从而最大程度地减少服务中断时间。

一个典型的FA系统包含以下关键要素:

- 主/备节点: 至少包含两台服务器,一台作为主节点对外提供服务,另一台或多台作为备用节点处于待命状态。

- 心跳检测: 主备节点之间通过专用或公共网络链路,周期性地发送“心跳”信号,用以确认对方是否处于正常工作状态,一旦主节点心跳丢失,系统即判定其发生故障。

- 资源切换: 故障被确认后,备用节点将自动接管主节点的资源,这可能包括虚拟IP地址、共享存储(如SAN或NAS)上的数据、运行的应用服务等。

- 自动恢复: 当故障的主节点修复后,可以选择手动或自动将其重新加入集群,恢复到初始的主备或活动/活动状态。

OC:自动编排与配置

如果说FA解决了“如何切换”的问题,那么OC则专注于“如何让切换变得更智能、更高效、更少人工干预”,OC是整个体系的“大脑”,它超越了简单的故障切换,实现了从资源准备、服务部署到故障恢复的全生命周期自动化管理。

OC的核心能力体现在:

- 标准化配置: 通过使用配置管理工具(如Ansible, Puppet, SaltStack)或基础设施即代码,确保所有服务器(包括主备节点)的操作系统、软件环境、网络配置等保持高度一致和标准化,这避免了因配置不一致导致的切换失败风险。

- 流程编排: 将复杂的故障切换过程编排成一个自动化的工作流,当检测到主节点故障时,OC流程不仅仅是启动备用服务,还可能包括:通知运维团队、在云平台上动态申请额外资源、更新DNS解析记录、执行数据一致性检查等一系列精细化操作。

- 智能监控与决策: 结合Prometheus、Zabbix等监控系统,OC平台不仅能判断服务器“死活”,还能基于CPU负载、内存使用率、应用响应时间等多维度指标进行综合分析,实现预测性故障转移或负载均衡。

FA与OC的结合,使得高可用性系统从一个被动的“应急开关”进化为一个主动的、智能的“自适应系统”。

服务器FA/OC架构的关键组件与优势

一个完整的FA/OC解决方案通常需要硬件和软件的协同工作。

| 组件类别 | 关键要素 | 在FA/OC中的作用 |

|---|---|---|

| 硬件层 | 冗余电源、RAID磁盘阵列、多网卡、共享存储 | 提供物理层面的可靠性基础,防止单点硬件故障导致整个系统宕机。 |

| 网络层 | 多线路接入、负载均衡器、虚拟IP(VIP) | 保证网络路径的冗余,并实现流量的平滑切换与分发。 |

| 软件层 | 集群软件(如Windows Server Failover Clustering, Pacemaker)、虚拟化平台(如VMware HA, Proxmox VE) | 实现心跳检测、资源管理和故障切换的核心逻辑。 |

| 管理层 | 配置管理工具(Ansible)、容器编排平台(Kubernetes)、监控系统 | 负责自动化部署、配置同步、状态监控和流程编排,是OC能力的载体。 |

实施服务器FA/OC架构能为企业带来显著的优势:

- 极致的业务连续性: 将计划外停机时间从小时级缩短至秒级甚至毫秒级,保障核心业务7×24小时不间断运行。

- 数据安全与一致性: 通过共享存储或实时数据同步技术,确保主备节点数据一致,避免切换时发生数据丢失。

- 降低运维成本: 自动化流程大幅减少了人工干预的需求,使运维团队能从繁琐的应急处理中解放出来,专注于更具价值的优化工作。

- 提升系统弹性与可扩展性: 基于标准化的配置和自动化的编排,可以快速地根据业务需求扩展或缩减服务器资源,适应动态变化的负载。

实施路径与最佳实践

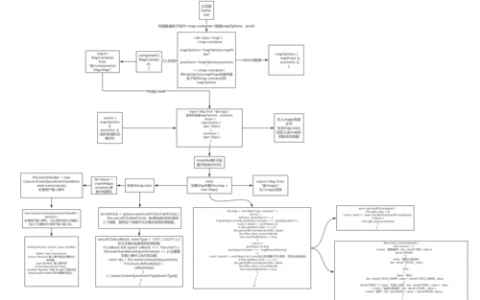

构建一个稳健的服务器FA/OC系统并非一蹴而就,通常遵循以下步骤:

- 需求分析与规划: 明确业务对RTO(恢复时间目标)和RPO(恢复点目标)的要求,确定需要保护的关键应用和服务。

- 架构设计: 选择合适的FA/OC技术栈(如基于物理机集群、虚拟化HA或云原生高可用方案),设计网络拓扑和存储架构。

- 环境准备: 部署标准化的硬件和软件环境,利用配置管理工具确保所有节点的一致性。

- 部署与配置: 安装和配置集群软件、监控系统和自动化编排工具,定义故障切换策略和自动化工作流。

- 测试与验证: 进行反复的、模拟真实场景的故障切换测试,验证系统的有效性、稳定性和切换时间,并根据测试结果进行优化。

- 监控与维护: 建立完善的监控告警机制,定期回顾系统运行状态,持续更新和完善自动化脚本与策略。

相关问答(FAQs)

问:服务器FA/OC和我们通常说的数据备份有什么核心区别?

答: 两者的核心目标和作用机制完全不同,数据备份是一种“事后恢复”机制,它侧重于在数据发生丢失或损坏后,将历史数据恢复到某个时间点,过程中必然存在服务中断和数据丢失(RPO>0),而服务器FA/OC是一种“事中接管”机制,它通过冗余和自动化,在主系统发生故障的瞬间,将服务无缝切换到备用系统,目标是让用户几乎感知不到中断(RTO接近0),并且通过实时同步技术保证数据不丢失(RPO=0),备份是“亡羊补牢”,而FA/OC是“未雨绸缪”和“瞬间换胎”。

问:对于中小企业而言,实施服务器FA/OC的成本是不是非常高?

答: 过去,构建高可用性集群确实需要昂贵的专用硬件和软件,成本门槛较高,但随着技术的发展,尤其是开源软件和云计算的普及,中小企业实施FA/OC的成本已大幅下降,可以利用两台普通x86服务器,配合开源的Pacemaker集群软件和Ansible自动化工具,构建出成本可控且功能强大的高可用解决方案,在云环境下,平台本身即提供了许多高可用性组件(如负载均衡器、自动伸缩组),企业可以按需组合,以更低的运维成本实现类似FA/OC的效果,关键在于根据自身业务需求和预算,选择最适合的技术路径,而非一概而论地认为其高不可攀。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复