Array负载均衡器透明模式是一种高效的网络流量调度技术,其核心在于让负载均衡设备在网络中对客户端和服务器保持“隐形”状态,即客户端无需感知负载均衡器的存在,服务器也无需修改原有配置即可接收流量,这种模式通过简化网络架构、降低部署复杂度,成为企业级应用中实现高可用、高性能负载均衡的重要选择。

透明模式的工作原理

透明模式的实现依赖于负载均衡器在网络中的“中间层”角色,通过巧妙的网络协议转发机制,使数据包在客户端与服务器之间无缝传递,其工作流程可分为两个关键阶段:

客户端请求转发

客户端发起请求时,目标IP为虚拟IP(VIP,即服务集群的对外访问地址),负载均衡器通过监听VIP接收请求后,根据预设的负载均衡算法(如轮询、加权轮询、最少连接等)选择后端服务器,并通过网络地址转换(NAT)或直接路由(Direct Routing)技术将请求转发至选定的服务器。

- SNAT模式:负载均衡器将客户端源IP替换为自身IP,服务器响应时默认发往负载均衡器,再由负载均衡器转发回客户端,此模式下,服务器无法直接获取客户端真实IP,需通过负载均衡器插入的HTTP头(如X-Forwarded-For)获取。

- 直接路由模式:负载均衡器仅修改数据包的目标MAC地址(二层转发),服务器响应时直接通过路由将数据包返回客户端,此时服务器可获取客户端真实IP,但需确保服务器网关指向负载均衡器,且负载均衡器与服务器在同一子网或路由可达。

服务器响应返回

服务器处理完请求后,根据转发模式选择响应路径:SNAT模式下,响应数据包发往负载均衡器,负载均衡器替换源IP为VIP后返回客户端;直接路由模式下,响应数据包直接发往客户端,减少一次网络跳转,降低延迟。

透明模式的核心优势

与传统“非透明”模式(如需修改服务器网关或客户端配置)相比,透明模式凭借以下特性成为企业部署的首选:

零配置兼容性

透明模式无需修改客户端和服务器端的IP配置、网关或应用层代码,在现有服务器集群中插入负载均衡器时,服务器无需重新配置网关,客户端也无需感知VIP的存在,极大降低了迁移和部署成本。

网络拓扑灵活性

支持串联部署(如串接在防火墙后)和并联部署(如与核心交换机并行),可根据网络环境灵活调整位置,兼容VLAN、多子网等复杂网络架构,适用于数据中心、混合云等多样化场景。

安全与性能兼顾

负载均衡器作为流量入口,可集中部署安全策略(如DDoS防护、WAF、SSL卸载),避免安全设备分散导致的配置复杂,通过直接路由模式减少NAT转换开销,提升转发效率;支持硬件加速(如ASIC芯片),满足高并发场景下的性能需求。

动态扩展与高可用

支持动态添加/移除后端服务器,通过健康检查自动剔除故障节点,确保流量仅转发至健康服务器,结合负载均衡器集群模式(如VRRP、HSRP),可实现设备级高可用,避免单点故障。

典型应用场景

透明模式凭借其透明性和兼容性,广泛应用于需要高可用、高性能流量调度的场景:

Web应用服务

电商、门户网站等Web应用需应对海量并发请求,透明模式可将流量分发至多台Web服务器,通过轮询或加权轮询算法均衡负载,同时支持会话保持(如基于Cookie或源IP),确保用户请求始终路由至同一服务器。

数据库集群读写分离

在主从数据库架构中,透明模式可将读请求分发至多个从库,写请求定向至主库,通过“读写分离”降低主库压力,直接路由模式可让从库直接响应客户端,减少延迟,提升查询效率。

微服务架构流量调度

微服务架构中,服务实例动态变化频繁,透明模式无需修改服务注册中心配置即可自动发现新实例,通过服务名或API路径将请求分发至对应服务实例,简化服务治理复杂度。

云环境混合部署

在混合云场景中,本地服务器与云服务器需协同提供服务,透明模式可通过统一VIP调度跨地域流量,结合云服务商的负载均衡能力,实现本地与云资源的弹性扩展。

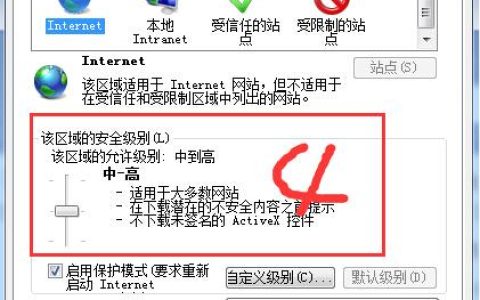

配置要点与注意事项

核心配置步骤

以Array负载均衡器为例,透明模式配置需关注以下步骤:

- 网络接口配置:设置外网接口(绑定VIP)和内网接口(连接后端服务器),确保接口路由可达。

- VIP与服务器池创建:配置虚拟IP(VIP),添加后端服务器IP至服务器池,设置服务器权重(基于性能差异)。

- 负载均衡算法选择:根据业务需求选择算法(如高并发场景选最少连接,性能均衡场景选加权轮询)。

- 健康检查配置:设置TCP/HTTP检查,检查间隔、超时时间和失败阈值,确保故障服务器及时下线。

- NAT模式选择:根据是否需要客户端真实IP选择SNAT或直接路由,直接路由需确保服务器网关指向负载均衡器内网接口。

关键注意事项

- 网络规划:避免负载均衡器与服务器形成环路,确保路由表正确;直接路由模式下,负载均衡器与服务器需在同一子网或三层路由可达。

- SNAT配置:若服务器需访问外网,需配置SNAT规则,否则服务器响应无法返回客户端。

- 性能监控:实时监控负载均衡器的CPU、内存、带宽及后端服务器的连接数、响应时间,避免性能瓶颈。

负载均衡算法对比表

| 算法名称 | 工作原理 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|---|

| 轮询(Round Robin) | 按顺序将请求分配给服务器 | 服务器性能均衡、无状态应用 | 简单易用,配置成本低 | 未考虑服务器负载差异 |

| 加权轮询(WRR) | 根据服务器权重分配请求(权重越高,分配越多) | 服务器性能差异较大(如CPU、内存不同) | 可根据性能调整负载分配 | 权重需手动调整,动态性差 |

| 最少连接(LC) | 将请求分配给当前连接数最少的服务器 | 服务器负载波动大、长连接应用 | 实时反映服务器负载,均衡效果好 | 需实时监控连接数,开销略高 |

| 加权最少连接(WLC) | 结合权重和连接数分配请求 | 服务器性能和负载均差异较大 | 精准均衡负载,动态适应性强 | 计算复杂度较高,需更多资源 |

相关问答FAQs

问题1:透明模式下,后端服务器如何获取客户端的真实IP地址?

解答:默认情况下,SNAT模式下服务器看到的源IP为负载均衡器IP,若需获取客户端真实IP,可通过以下方式实现:

- Proxy Protocol:负载均衡器与服务器间启用Proxy Protocol,在TCP连接建立时传输客户端IP、端口等信息,服务器需支持Proxy Protocol解析(如Nginx、HAProxy)。

- HTTP头插入:负载均衡器在转发HTTP请求时插入X-Forwarded-For或X-Real-IP字段,服务器通过读取HTTP头获取客户端IP(需应用层支持)。

- 直接路由模式:服务器直接响应客户端,此时服务器源IP为客户端真实IP,但需确保服务器网关指向负载均衡器,且负载均衡器配置允许直接路由。

问题2:透明模式与传统NAT模式的主要区别是什么?

解答:两者核心区别在于“透明性”和“网络路径”:

- 部署透明性:透明模式无需修改服务器网关和客户端配置,服务器感知不到负载均衡器的存在;传统NAT模式通常需将服务器网关指向负载均衡器,客户端需感知VIP,存在“中间层”感知。

- IP转换方式:透明模式可选择SNAT(隐藏服务器IP)或直接路由(服务器直接响应客户端,IP不转换);传统NAT模式强制进行源/目标IP转换,服务器始终看到负载均衡器IP。

- 响应路径:透明模式直接路由下,服务器响应直接返回客户端,减少网络跳转;传统NAT模式下,响应需经负载均衡器返回,增加延迟和负载均衡器压力。

- 适用场景:透明模式适合对透明性要求高、不想改动现有架构的场景;传统NAT模式适合需要严格隔离服务器网络、隐藏服务器真实IP的场景。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复