服务器显卡显存作为数据中心和AI计算的核心组件,直接决定了系统的数据处理能力和任务效率,与消费级显卡不同,服务器显卡显存更注重稳定性、容量和带宽,以满足高并发、高负载的计算需求,本文将从显存类型、容量选择、技术特点及应用场景等方面展开分析。

显存类型:性能与功耗的平衡

服务器显卡显存主要采用GDDR6、HBM2e和HBM3三种技术,GDDR6凭借成熟的技术和较高的性价比,在中低端服务器显卡中广泛应用,其带宽可达16-48Gbps,适合常规数据中心任务,HBM2e通过堆叠设计实现更大带宽(如2.4TB/s)和更低功耗,但成本较高,多用于AI训练和高性能计算(HPC),HBM3作为最新技术,进一步将带宽提升至3.6TB/s以上,支持更大容量(如80GB),是未来大模型训练和超算中心的首选,下表对比了三种显存的关键参数:

| 显存类型 | 带宽范围 | 单颗容量 | 功耗优势 | 典型应用场景 |

|---|---|---|---|---|

| GDDR6 | 16-48Gbps | 8-24GB | 中等 | 常规数据中心、推理服务 |

| HBM2e | 3-2.4TB/s | 16-32GB | 高 | AI训练、HPC、科学计算 |

| HBM3 | 4-3.6TB/s以上 | 24-80GB | 极高 | 大模型训练、超算中心 |

显存容量:匹配计算需求的核心

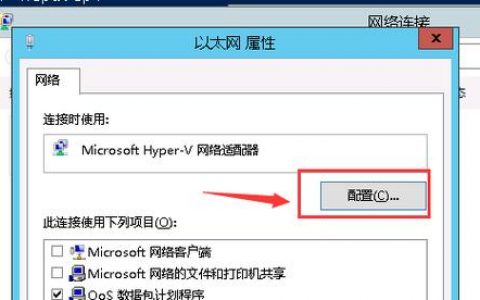

显存容量直接影响服务器可处理的数据规模,以AI训练为例,大模型(如GPT-4)通常需要80GB以上的显存来容纳参数矩阵;而推理任务或中小型数据库,16-32GB显存即可满足需求,多卡互联技术(如NVIDIA NVLink)可通过跨卡扩展虚拟显存,进一步提升系统灵活性,8张A100显卡(每卡80GB HBM2e)通过NVLink可形成640GB统一显存池,支持万亿参数模型的并行训练。

技术特点:稳定与可扩展性

服务器显卡显存需满足7×24小时不间断运行的要求,因此采用ECC(错误纠正码)技术,可检测并修复单比特错误,降低数据损坏风险,显存位宽(如384bit-512bit)和通道设计进一步优化数据传输效率,避免成为性能瓶颈,NVIDIA H100显卡的50MB二级缓存配合HBM3显存,可实现高达3TB/s的片带宽数据传输,显著提升大模型训练效率。

应用场景驱动显存选择

- AI训练:大模型训练依赖高带宽和大容量显存,如HBM3或HBM2e,配合多卡扩展技术。

- 推理服务:对显存带宽要求较低,GDDR6或HBM2e更具性价比,可降低部署成本。

- HPC与科学计算:如气候模拟、基因测序,需高精度计算和低延迟数据访问,HBM2e/HBM3为首选。

- 虚拟化与云服务:多租户场景需显存动态分配技术,如NVIDIA MIG,可将单卡显存划分为7个独立实例。

相关问答FAQs

Q1:显存容量不足时,会对服务器性能造成哪些影响?

A1:显存容量不足会导致数据处理效率下降,例如AI训练中出现“显存溢出”错误,需减少批次大小或模型规模;推理任务可能因缓存不足而延迟增加,频繁的显存交换(与硬盘虚拟内存交互)会显著拉低系统响应速度。

Q2:如何根据预算选择合适的服务器显卡显存配置?

A2:预算有限时,可优先考虑GDDR6显存的中端显卡(如NVIDIA T4),满足常规推理和虚拟化需求;若需AI训练或HPC,建议投资HBM2e显卡(如A100),通过多卡扩展平衡成本与性能;长期规划可关注HBM3显卡(如H100),虽初期投入高,但能适应未来大模型算力需求。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复