创建大数据库是一个系统性工程,涉及技术选型、架构设计、数据管理、性能优化等多个环节,无论是企业级应用还是科研场景,都需要从实际需求出发,遵循科学的方法论,确保数据库的稳定性、扩展性和安全性,以下从关键步骤和核心要点展开说明。

明确需求与目标

在创建大数据库前,需首先明确业务场景和核心需求,是用于海量交易数据的实时处理,还是用于历史数据的分析与挖掘?不同需求直接影响技术选型和架构设计,需梳理以下关键问题:数据规模(TB/PB级?)、数据类型(结构化/非结构化?)、读写频率(高并发读还是高并发写?)、延迟要求(实时还是离线?),还需考虑未来3-5年的数据增长趋势,预留扩展空间。

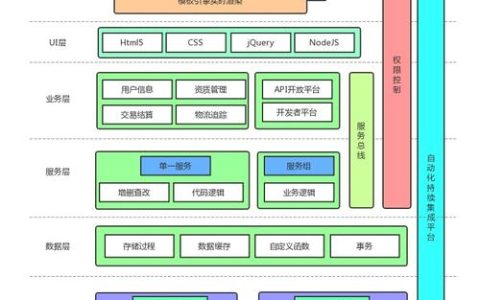

技术选型与架构设计

根据需求选择合适的数据库类型和架构,目前主流的大数据存储方案包括:

分布式数据库

适用于高并发、高可用的场景,如金融、电商等,代表技术有:

- NewSQL(如Google Spanner、TiDB):结合传统SQL的强一致性与分布式扩展性,适合事务性强的业务。

- NoSQL(如MongoDB、Cassandra):灵活处理非结构化数据,适合高并发写入场景。

数据仓库

侧重数据分析与决策支持,如:

- MPP架构(如Greenplum、ClickHouse):通过分布式并行计算提升查询性能,适合复杂分析查询。

- 湖仓一体(如Delta Lake、Iceberg):融合数据湖的灵活性与数据仓库的管理能力,支持结构化和非结构化数据统一存储。

存储与计算分离架构

如基于HDFS或对象存储(S3、OSS)+ Spark/Flink计算引擎,适合弹性扩展需求,成本控制更灵活。

表:主流数据库技术对比

| 类型 | 代表技术 | 优势 | 适用场景 |

|—————-|——————–|———————————–|————————–|

| NewSQL | TiDB, CockroachDB | 强一致性、ACID事务、水平扩展 | 金融、电商核心交易系统 |

| NoSQL | MongoDB, Cassandra | 高吞吐、灵活模式、易扩展 | 物联网日志、社交网络 |

| 数据仓库 | ClickHouse, Snowflake | 高性能分析、SQL兼容、实时查询 | 商业智能、大数据分析 |

| 湖仓一体 | Delta Lake, Iceberg | 统一存储、ACID支持、批流一体 | 数据中台、AI训练数据存储 |

数据建模与分区设计

合理的数据模型能显著提升查询效率,对于关系型数据库,需规范化和反规范化权衡;对于NoSQL,需根据查询模式设计文档或键值结构,分区(Partitioning)是提升大数据库性能的关键,可按时间、地域、业务维度分区,减少单表数据量,ClickHouse按日期分区可快速裁剪数据范围,TiDB按Region分布可实现负载均衡。

高可用与容灾方案

大数据库需避免单点故障,常见方案包括:

- 多副本机制:如MySQL主从复制、MongoDB副本集,确保数据冗余。

- 跨机房部署:通过异地多活(如AWS Multi-AZ)或灾备中心,应对区域性灾难。

- 定期备份与恢复测试:结合全量备份+增量日志(Binlog/WAL),制定RTO(恢复时间目标)和RPO(恢复点目标)。

性能优化与监控

索引优化:避免全表扫描,合理创建B树、位图等索引,但需注意写入性能损耗。

查询优化:通过EXPLAIN分析执行计划,避免复杂子查询,使用物化视图预计算。

资源隔离:对关键业务使用CPU/内存资源限制,防止单个查询影响整体性能。

监控体系:部署Prometheus+Grafana监控QPS、延迟、资源使用率,设置告警阈值。

安全与合规

数据安全是大数据库的核心要求:

- 访问控制:基于RBAC(角色权限控制)最小化权限分配,定期审计操作日志。

- 数据加密:传输层(TLS)和存储层(TDE、AES加密)双重防护。

- 合规性:满足GDPR、等保等法规,匿名化敏感数据,保留审计追踪。

扩展与迭代

数据量增长可能导致架构瓶颈,需预留扩展路径:

- 水平扩展:通过增加节点提升存储和计算能力(如TiDB的Add-TiKV)。

- 冷热数据分离:热数据(高频访问)存SSD,冷数据归档至低成本存储(如HDD、对象存储)。

- 定期评估:每半年审查架构,引入新技术(如向量化引擎、AI优化)提升效率。

FAQs

Q1: 如何选择关系型数据库和NoSQL数据库?

A1: 需根据数据结构和业务需求判断:若数据结构固定、需强事务(如订单系统),选MySQL、TiDB等关系型数据库;若数据模式灵活、写入量大(如日志存储),选MongoDB、Cassandra等NoSQL,也可通过“关系型+NoSQL”混合架构(如MySQL+Redis)互补。

Q2: 大数据库如何应对高并发写入场景?

A2: 可从三方面优化:1)架构层面采用分库分表(如ShardingSphere)或分布式数据库(如TiDB)分散压力;2)写入端使用批量插入(Bulk Insert)替代单条插入,减少IO次数;3)引入消息队列(Kafka、Pulsar)削峰填谷,异步写入数据库,避免系统阻塞。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复