在数字化转型的浪潮中,人工智能(AI)技术已成为推动各行各业创新的核心驱动力,AI模型的训练与推理过程对计算资源的需求极为庞大,尤其是大规模深度学习任务,往往需要强大的算力支持,在此背景下,AI解码服务器应运而生,它专为高效处理AI推理任务而设计,通过优化的硬件架构和软件栈,实现模型从输入数据到输出结果的快速、精准转换,成为支撑AI应用落地的关键基础设施。

AI解码服务器的核心功能与定位

AI解码服务器与传统的通用服务器或AI训练服务器存在显著差异,其核心定位在于“高效推理”,即针对已训练好的AI模型,实时处理输入数据并生成输出结果,这一过程被称为“解码”,尤其在自然语言处理(NLP)、计算机视觉(CV)等领域,模型需要将复杂的数学运算转化为人类可理解的信息(如文本、图像),解码服务器的性能直接决定了AI应用的响应速度和用户体验。

与训练服务器侧重于大规模并行计算不同,解码服务器更强调低延迟、高吞吐量和能效比,在智能客服场景中,服务器需在毫秒级内完成用户问题的语义理解并生成回复;在自动驾驶领域,实时处理摄像头数据并做出决策更是对解码性能的极致考验,AI解码服务器在硬件选型、软件优化和架构设计上均围绕“推理效率”这一核心目标展开。

硬件架构:算力与能效的平衡

AI解码服务器的硬件配置是其性能的基础,当前主流的解码服务器多采用异构计算架构,整合CPU、GPU、TPU(张量处理单元)或专用ASIC(专用集成电路)等多种计算单元,以适应不同模型的计算需求。

- GPU:如NVIDIA的A100、H100系列,凭借强大的并行计算能力,成为处理大规模CV模型和NLP模型的首选,尤其在支持半精度(FP16)或INT8量化推理时,能显著提升吞吐量。

- 专用ASIC:如Google的TPU或华为昇腾系列,针对特定AI算法进行硬件级优化,能以更低的功耗实现更高的解码效率,适合对能效比要求严苛的场景。

- CPU+加速卡组合:对于轻量级模型或边缘计算场景,采用多核CPU搭配AI加速卡(如Intel Gaudi)的方案,可在成本与性能间取得平衡。

高速内存(如HBM2e)和低延迟互联技术(如NVLink)也是解码服务器的关键配置,确保数据在计算单元间的高效流转,避免瓶颈。

软件栈优化:从模型到部署的效率提升

硬件性能的发挥离不开软件栈的协同优化,AI解码服务器的软件层通常包括模型编译工具、推理引擎和自动化管理平台,旨在简化部署流程并最大化硬件利用率。

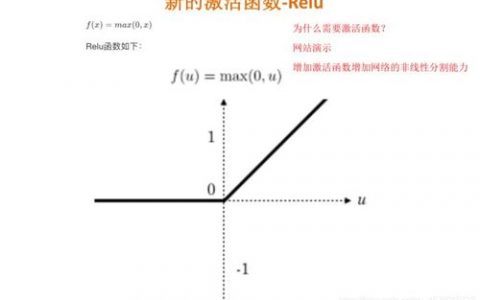

- 模型编译与优化:通过TensorRT、ONNX Runtime等工具,将训练好的模型转换为针对特定硬件优化的格式,如算子融合、常量折叠等技术可减少计算冗余,提升推理速度。

- 推理引擎:如NVIDIA Triton Inference Server或vLLM,支持动态批处理、模型版本管理和多框架部署,能够根据负载情况自动分配资源,实现高并发请求的高效处理。

- 量化与剪枝:通过INT8量化或模型剪枝技术,在精度损失可控的前提下大幅降低模型计算量和显存占用,进一步加快解码速度。

以NLP模型为例,传统CPU推理可能需要数百毫秒,而经过优化后的解码服务器可在10毫秒内完成相同任务,效率提升数十倍。

典型应用场景与性能对比

AI解码服务器的应用已渗透至多个领域,以下列举几个典型场景及其性能需求:

| 应用场景 | 典型模型 | 性能需求 | 解码服务器优势 |

|---|---|---|---|

| 智能客服 | GPT系列、BERT | 低延迟(<100ms)、高并发 | 支持动态批处理,提升并发响应能力 |

| 自动驾驶 | YOLO、Transformer | 实时性(<50ms)、高可靠性 | 异构架构加速多传感器数据融合 |

| 医学影像分析 | U-Net、ResNet | 高精度、稳定输出 | 专用ASIC保障诊断结果的准确性 |

| 工业质检 | Faster R-CNN | 高吞吐(>1000 FPS)、抗干扰 | GPU并行处理提升检测效率 |

未来发展趋势

随着AI模型的持续迭代和应用场景的拓展,AI解码服务器将呈现以下发展趋势:

- 边缘化部署:5G和物联网的普及推动解码服务器向边缘端延伸,实现“端-边-云”协同推理,降低数据传输延迟。

- 绿色低碳:通过芯片制程升级(如3nm工艺)和能效优化算法,降低单次推理的能耗,符合全球碳中和目标。

- 自动化运维:结合AIOps技术,实现资源调度、故障预测和性能调优的智能化,进一步降低运维成本。

相关问答FAQs

Q1: AI解码服务器与AI训练服务器的主要区别是什么?

A1: 两者的核心区别在于任务目标:AI训练服务器侧重于大规模数据并行计算,通过迭代优化模型参数(如使用多GPU集群进行梯度下降),而AI解码服务器专注于高效推理,通过硬件加速和软件优化实现低延迟、高吞吐的模型部署,训练服务器对内存带宽和存储容量要求更高,解码服务器则更强调实时性和能效比。

Q2: 如何选择适合自身业务的AI解码服务器?

A2: 选择时需综合考虑以下因素:

- 模型类型:CV模型优先选择GPU,轻量级NLP模型可考虑CPU+加速卡组合;

- 性能需求:对延迟敏感的场景(如自动驾驶)需选用专用ASIC,对成本敏感的场景可评估云服务按需付费方案;

- 扩展性:预留硬件升级和横向扩展能力,以应对未来模型复杂度的提升;

- 生态支持:优先选择兼容主流框架(如TensorFlow、PyTorch)并提供完善工具链的服务器,简化部署流程。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复