服务器延迟处理是现代网络架构中不可忽视的关键环节,它直接影响用户体验、业务效率和系统稳定性,在分布式系统、云计算和大数据时代,随着用户量和数据量的爆炸式增长,延迟问题愈发复杂,如何高效处理延迟成为技术团队的核心挑战之一。

服务器延迟的成因与影响

服务器延迟通常由多种因素导致,包括网络带宽限制、服务器硬件性能瓶颈、软件算法效率低下、数据库查询缓慢以及地理位置分布不均等,跨国业务中物理距离造成的网络传输延迟,或高并发场景下CPU资源争用导致的响应滞后,延迟带来的影响是多维度的:对用户而言,页面加载时间每增加1秒,跳出率可能上升7%;对企业而言,交易延迟可能导致订单丢失,金融系统中的毫秒级延迟甚至可能造成巨大经济损失。

延迟处理的技术策略

网络优化

网络是延迟的主要来源之一,优化网络拓扑结构可显著降低延迟,采用CDN(内容分发网络)将静态资源部署到离用户最近的节点,减少物理传输距离;通过多线BGP(边界网关协议)接入多家运营商,避免单点故障;启用QUIC协议(基于UDP的快速互联网连接)替代传统TCP,减少握手次数,提升传输效率,视频平台通过CDN将内容缓存到边缘节点,使全球用户访问延迟降低40%以上。

硬件与软件升级

硬件方面,使用SSD替代HDD提升磁盘I/O速度,部署多核CPU和高速内存(如DDR5)增强数据处理能力;软件层面,通过代码重构减少算法时间复杂度,使用异步编程模型(如Node.js的Event Loop)避免I/O阻塞,并引入缓存机制(如Redis、Memcached)减少重复计算,以电商平台为例,通过引入Redis缓存热门商品信息,数据库查询延迟从50ms降至5ms。

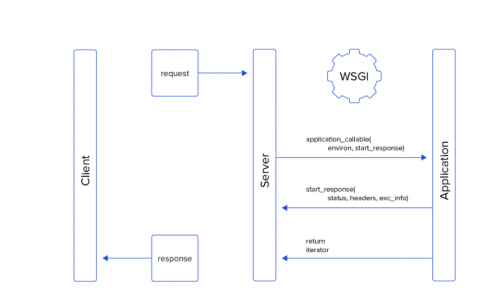

架构设计与容错机制

采用微服务架构将单体应用拆分为独立服务,减少单个服务的负载压力;通过负载均衡(如Nginx、HAProxy)将请求分发到多个服务器,避免单点过载;引入熔断器(如Hystrix)和限流机制(如Sentinel),在系统过载时拒绝部分请求,保障核心功能可用,金融系统中,异地多活架构通过数据同步和请求路由,即使单区域故障也能保证业务连续性,延迟控制在200ms以内。

延迟监控与性能调优

实时监控是延迟处理的基础,通过APM(应用性能监控)工具(如SkyWalking、Pinpoint)采集接口响应时间、数据库查询耗时等指标,设置阈值告警;利用压力测试工具(如JMeter、Locust)模拟高并发场景,定位性能瓶颈,某社交平台通过监控发现用户消息推送延迟异常,最终排查出是由于消息队列堆积导致,通过扩容队列和优化消费者逻辑解决问题。

不同场景下的延迟处理实践

| 场景 | 延迟要求 | 核心技术 | 案例效果 |

|---|---|---|---|

| 在线游戏 | <50ms | 边缘计算、UDP协议、预测算法 | 玩家操作延迟降低至30ms内 |

| 高频交易 | <1ms | FPGA硬件加速、专线网络、内存数据库 | 交易撮合延迟控制在0.8ms |

| 视频直播 | <2s | 动态码率调整、P2P分发、低延迟协议 | 首屏加载时间缩短至1.5秒 |

相关问答FAQs

Q1: 如何判断服务器延迟是否在合理范围?

A1: 延迟的合理范围需结合业务场景判断,静态网页加载时间应<2秒,API接口响应时间<200ms为良好,>1秒则需优化;实时游戏要求延迟<50ms,而视频直播可接受<2秒,可通过APM工具监控P95(95%请求的延迟)或P99(99%请求的延迟)指标,避免极端值影响整体体验。

Q2: 延迟处理中,缓存与数据库优化的优先级如何?

A2: 优先级需根据业务特点确定:读多写少的场景(如电商商品详情)应优先引入缓存,减少数据库压力;写多读少或强一致性的场景(如金融交易)则需优先优化数据库(如分库分表、索引优化),实践中可结合缓存穿透、雪崩等问题的防护措施,例如使用布隆过滤器防止无效请求访问数据库,或设置缓存过期时间避免数据不一致。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复