在数据管理和信息处理的日常工作中,确保数据库内容的唯一性和准确性至关重要,重复的数据库不仅会占用存储资源,还可能导致数据冗余、查询效率低下,甚至引发业务逻辑混乱,掌握有效的数据库重复检查方法,是每个数据管理员和开发人员必备的技能,本文将系统介绍几种主流的数据库重复检查方法,涵盖从基础工具到高级脚本的多种技术,帮助读者根据实际场景选择合适的解决方案。

使用数据库内置工具进行重复检查

大多数主流数据库管理系统(DBMS)都提供了内置的工具或功能,可以直接用于检测重复数据,这些工具通常与数据库引擎深度集成,操作简单且效率较高。

MySQL/MariaDB

在MySQL中,可以通过GROUP BY子句结合HAVING条件来快速查找重复记录,假设有一个名为users的表,需要检查email字段是否存在重复,可以执行以下SQL查询:

SELECT email, COUNT(*) as count FROM users GROUP BY email HAVING count > 1;

如果需要定位具体的重复记录,可以进一步使用子查询或JOIN操作,MySQL的information_schema数据库也提供了元数据查询功能,可用于分析表结构和数据分布。

PostgreSQL

PostgreSQL提供了更强大的窗口函数(Window Functions),非常适合复杂的重复检测场景,使用ROW_NUMBER()函数可以为重复记录分配序号,从而筛选出重复项:

WITH numbered_rows AS (

SELECT *, ROW_NUMBER() OVER (PARTITION BY email ORDER BY id) as row_num

FROM users

)

SELECT * FROM numbered_rows WHERE row_num > 1; PostgreSQL的pg_stat_user_tables视图还可以提供表的统计信息,帮助预估重复数据的可能性。

SQL Server

SQL Server的DENSE_RANK()函数与PostgreSQL的窗口函数类似,可用于标记重复记录。

WITH duplicate_groups AS (

SELECT email, DENSE_RANK() OVER (PARTITION BY email ORDER BY id) as rank

FROM users

)

SELECT email FROM duplicate_groups WHERE rank > 1; SQL Server的“重复值”向导(通过SQL Server Management Studio图形界面操作)也为非技术人员提供了便捷的检测方式。

通过编程脚本实现自动化检查

对于需要复杂逻辑或批量处理的场景,使用编程脚本(如Python、PHP等)结合数据库连接库,可以实现更灵活的重复检测方案。

Python示例

Python的pandas库和数据库连接工具(如pymysql、psycopg2)是处理此类任务的利器,以下是一个简单的Python脚本,用于检测MySQL中users表的email重复项:

import pandas as pd

import pymysql

# 连接数据库

conn = pymysql.connect(host='localhost', user='root', password='password', db='test_db')

query = "SELECT * FROM users"

df = pd.read_sql(query, conn)

# 检测重复项

duplicates = df[df.duplicated(subset=['email'], keep=False)]

print("重复记录数量:", len(duplicates))

print(duplicates)

conn.close() 该脚本的优势在于可以轻松扩展,例如结合数据清洗、导出结果等功能。

其他语言支持

PHP的PDO扩展、Java的JDBC等同样支持通过编程方式查询数据库,并利用语言内置的数组或集合函数识别重复数据,PHP中可以使用array_count_values()统计字段值的出现频率。

利用第三方工具和平台

对于大型数据库或跨平台环境,专业的第三方工具能提供更高效的重复检测和管理功能。

数据库管理工具

- DBeaver:支持多种数据库,提供“数据比较”功能,可直接对比两个表或数据库的重复情况。

- Navicat:其“数据同步”功能可用于检测并合并重复数据。

- Redgate SQL Data Compare:专注于SQL Server,适合企业级数据对比。

开源工具

- OpenRefine:虽然主要用于数据清洗,但通过其聚类功能(Clustering)可以快速识别文本字段的重复值。

- Apache Griffin:大数据治理工具,提供数据质量检测框架,可自定义重复规则。

云数据库服务

- AWS Database Migration Service (DMS):支持在迁移过程中检测源数据库的重复数据。

- Azure SQL Database:通过“SQL Server Management Studio”可直接连接并执行重复检测查询。

预防数据库重复的最佳实践

除了事后检测,预防数据库重复更为重要,以下是几种常见策略:

- 唯一约束(UNIQUE Constraint):在表设计时为关键字段(如邮箱、身份证号)添加唯一约束,数据库会自动阻止重复插入。

- 索引优化:为频繁查询的字段创建索引,不仅能加速查询,也能通过索引快速定位重复项。

- 应用程序校验:在数据录入前,通过前端或后端逻辑进行重复检查,例如用户注册时验证邮箱唯一性。

- 定期审计:设置定时任务(如Cron Job),定期执行重复检测脚本并生成报告。

不同场景下的方法选择建议

| 场景 | 推荐方法 | 优点 | 缺点 |

|---|---|---|---|

| 小型数据库,快速检查 | 数据库内置SQL查询 | 无需额外工具,执行效率高 | 需要手动编写SQL,灵活性较低 |

| 大型数据库,复杂逻辑 | Python/Java脚本+Pandas | 可扩展性强,支持自定义处理逻辑 | 需要编程基础,配置较复杂 |

| 跨平台数据库对比 | 第三方工具(如DBeaver、Redgate) | 图形化界面,支持多数据库类型 | 可能需要付费,学习成本较高 |

| 实时防重复需求 | 数据库唯一约束+应用程序校验 | 从源头杜绝重复,自动化程度高 | 需要在设计和开发阶段提前规划 |

相关问答FAQs

Q1: 如何快速定位并删除重复数据?

A: 定位重复数据可参考前文方法,删除时需谨慎操作,以MySQL为例,可先通过GROUP BY和HAVING找出重复记录的主键ID,然后使用DELETE语句结合子查询删除非保留的重复项。

DELETE FROM users WHERE id NOT IN (

SELECT MIN(id)

FROM users

GROUP BY email

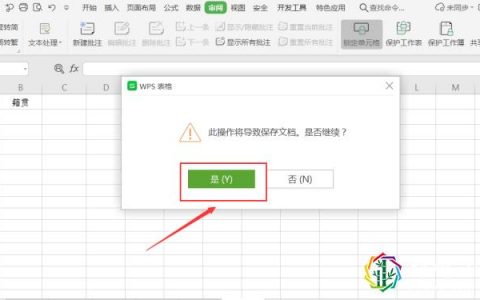

); 建议在操作前备份数据库,并在测试环境中验证脚本逻辑。

Q2: 对于大数据量(千万级以上),如何优化重复检测的性能?

A: 大数据量检测时,性能优化是关键,可采取以下措施:

- 分批处理:将数据按范围(如ID分片)分批查询,避免单次查询占用过多内存。

- 创建临时表:将目标字段数据导入临时表并创建索引,加速分组和排序操作。

- 使用并行查询:如PostgreSQL的

SET max_parallel_workers_per_gather = 4;可启用并行执行。 - 限制字段范围:仅检测关键字段,避免全表扫描,若

email和phone是唯一性字段,则只检查这两个字段而非所有列。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复