在现代网络架构中,负载均衡设备作为流量的“智能调度中枢”,承担着分发请求、优化资源、提升服务可用性的关键作用,随着业务流量规模的增长和复杂度的提升,传统单设备负载均衡逐渐暴露出性能瓶颈、单点故障风险等问题,而“array负载均衡设备”(即阵列化负载均衡设备)通过分布式架构、集群化协同和智能化调度,成为应对大规模、高并发场景的核心解决方案。

array负载均衡设备的核心技术架构

array负载均衡设备并非简单堆叠硬件,而是通过多节点协同的阵列化设计,实现控制平面与数据平面的分离、资源池化与动态调度,其核心技术架构包含三个层面:

分布式转发架构

与传统单设备的集中式处理不同,array负载均衡设备采用多节点分布式转发,每个节点独立处理流量数据,通过高速背板网络或互联协议(如RDMA、InfiniBand)实现负载分担,8节点阵列可将千兆级流量分散至各节点,单节点故障时剩余节点自动接管流量,避免性能抖动。

集群化控制平面

控制平面通过集群协议(如VRRP、PIM SM或自研集群协议)实现统一管理,包括配置同步、状态监控、策略下发等,各节点实时共享会话表、健康检查状态、负载指标等信息,确保调度决策的一致性,当后端服务器健康状态变化时,控制平面可在毫秒级内更新全局调度策略,并下发给所有数据节点。

智能调度算法引擎

array负载均衡设备内置多维调度算法,除基础的轮询(RR)、加权轮询(WRR)外,还支持基于实时负载的动态算法(如最少连接、最少响应时间)、基于内容的应用层调度(如HTTP头、Cookie、URL参数)以及基于地理位置的调度(GSLB),电商大促期间,系统可实时监控各服务器CPU、内存、I/O负载,将请求动态转发至压力最小的节点,同时结合用户IP将海外流量调度至边缘节点,降低延迟。

array负载均衡设备的关键优势

与传统单设备相比,array负载均衡设备在性能、可靠性、扩展性和可管理性上实现全面突破,具体优势如下:

高可用性与容灾能力

通过多节点冗余设计,array设备消除单点故障风险,N+1集群架构中,1个节点故障时,剩余N个节点可自动承担全部流量;跨地域部署的双活阵列可实现数据中心级容灾,当主数据中心中断时,备用数据中心秒级接管业务,确保业务连续性(SLA可达99.999%)。

线性扩展能力

性能扩展不再依赖单设备硬件升级,通过增加节点即可实现“水平扩展”,单节点支持100Gbps吞吐量,8节点阵列理论吞吐量可达800Gbps,且扩展过程中无需中断业务(热插拔技术),这种弹性扩展模式特别适合业务流量快速增长的场景(如短视频、直播平台)。

应用层深度处理能力

现代array负载均衡设备集成SSL卸载、WAF(Web应用防火墙)、DDoS防护等应用层功能,分布式处理架构可避免单设备SSL解密性能瓶颈,8节点阵列可并行处理10万+ TPS的SSL加密流量,同时实时检测SQL注入、XSS攻击等威胁,保障业务安全。

统一管理平台

通过图形化控制台或API,管理员可集中监控整个阵列的流量状态、节点健康度、负载分布等指标,支持批量配置、策略热部署和自动化运维,结合Ansible等工具,可实现阵列节点的批量升级与策略下发,运维效率提升70%以上。

典型应用场景

array负载均衡设备凭借高性能与高可靠性,已成为大型业务系统的核心组件,主要应用于以下场景:

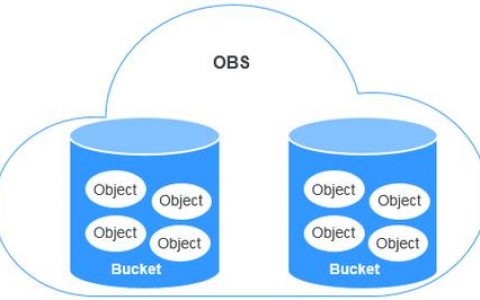

大型数据中心与云计算平台

在数据中心中,array负载均衡设备部署于服务器集群前端,分发用户请求至后端应用服务器、数据库服务器,支撑百万级并发访问,公有云服务商通过array阵列实现多租户流量隔离,确保不同客户业务互不干扰;私有云中,array设备与虚拟化平台(如VMware、K8s)集成,实现容器应用的自动发现与负载调度。

金融机构核心业务

银行、证券等金融机构对业务连续性和数据安全性要求极高,array负载均衡设备通过双活部署、同城容灾和加密传输,保障交易系统7×24小时稳定运行,某银行核心交易系统采用4节点阵列,结合智能调度算法,将交易请求分发至不同地域的数据中心,即使单数据中心故障,交易延迟仍控制在50ms以内。

互联网企业大促与直播场景

电商大促(如“双11”)、在线直播等场景下,流量会在短时间内激增数十倍,array负载均衡设备的弹性扩展能力可快速应对峰值流量,某电商平台通过“8+2”节点阵列(8个活动节点+2个备用节点),在峰值流量下实现99.99%的请求成功率,平均响应时间低于100ms。

部署模式与性能指标

array负载均衡设备根据业务需求可采用不同部署模式,其性能指标也直接决定业务承载能力。

部署模式对比

| 部署模式 | 适用场景 | 扩展方式 | 优势 | 挑战 |

|---|---|---|---|---|

| 本地阵列 | 企业自建数据中心 | 增加物理节点 | 数据本地化,低延迟 | 硬件投入大,机房空间要求高 |

| 混合阵列 | 本地+云混合云架构 | 本地节点+云节点扩容 | 跨云统一管理,弹性灵活 | 网络延迟管理复杂 |

| 云原生阵列 | 公有云/容器环境 | 弹性伸缩(云资源) | 按需付费,运维简化 | 依赖云厂商生态 |

核心性能指标

- 吞吐量:单节点吞吐量(如100Gbps/400Gbps),集群总吞吐量需满足业务峰值需求;

- 并发连接数:支持百万级并发连接(如10M并发),满足高并发业务场景;

- 延迟:转发延迟需低于10微秒(L3/L4层),应用层延迟低于1毫秒;

- 扩展能力:支持节点数量(如最大16节点),热插拔与动态扩展时间需小于1分钟。

挑战与未来趋势

尽管array负载均衡设备优势显著,但在部署与运维中仍面临复杂度高、成本投入大等挑战,随着技术演进,array负载均衡设备将呈现三大趋势:

AI驱动的智能调度

结合机器学习算法,实现流量预测与动态调度,通过历史流量数据预判峰值,提前扩容节点;基于用户行为分析,自动调整调度策略,优化用户体验。

与SDN/NFV深度融合

通过软件定义网络(SDN)实现流量路径的灵活编排,结合网络功能虚拟化(NFV)将负载均衡功能部署为虚拟服务,降低硬件依赖,提升资源利用率。

边缘计算适配

随着5G与边缘计算发展,轻量化阵列负载均衡设备将下沉至边缘节点,实现就近流量调度,降低时延,支撑AR/VR、自动驾驶等低时延业务。

相关问答FAQs

Q1:阵列负载均衡设备与单设备负载均衡的核心区别是什么?

A1:核心区别在于架构与能力,单设备负载均衡采用集中式处理,性能受限于硬件规格,存在单点故障风险;而阵列负载均衡设备通过多节点分布式架构,实现性能线性扩展、故障自动切换,同时支持应用层深度处理与智能化调度,更适合大规模、高可用性要求的业务场景。

Q2:选择阵列负载均衡设备时需要重点考虑哪些因素?

A2:需综合评估以下因素:①性能需求(吞吐量、并发连接数、延迟);②扩展能力(支持节点数量、弹性扩容效率);③可靠性(冗余设计、容灾机制);④兼容性(与现有网络设备、虚拟化平台/容器的集成能力);⑤运维便捷性(管理平台功能、API支持度);⑥成本(硬件投入、授权费用、运维成本)。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复