随着数字化转型的深入,云计算已成为支撑企业运营、社会服务和个人生活的新型基础设施,从最初的虚拟化资源池到如今的AI大模型训练、实时数据分析、边缘计算等复杂场景,云计算对算力的需求呈现爆炸式增长,传统通用芯片(如CPU、GPU)在能效比、成本控制和场景适配性上逐渐显露出瓶颈,专用集成电路(ASIC)芯片凭借其高性能、低功耗、高能效比的优势,正成为驱动云计算发展的核心引擎。

ASIC芯片(Application-Specific Integrated Circuit,专用集成电路)是针对特定应用场景或算法需求设计的集成电路,与通用芯片“一芯多用”的特性不同,ASIC通过硬件层面的深度定制,实现对特定任务的最优处理,在云计算领域,这一特性恰好契合了算力需求多样化、场景化的发展趋势,AI训练需要大规模并行计算能力,网络转发依赖低延迟数据处理,存储加速则追求高IOPS(每秒读写次数),而ASIC芯片可通过优化电路架构、精简冗余指令,为不同场景提供“量身定制”的算力支持。

ASIC芯片的技术特性与云计算需求的契合度

云计算的核心诉求可概括为“三高”:高算力、高能效、高性价比,ASIC芯片的技术特性恰好直击这些痛点。

高性能:ASIC针对特定算法(如矩阵运算、卷积运算)或任务(如数据包转发、加密解密)优化硬件架构,省去了通用芯片为兼容多种指令而设计的冗余电路,直接提升核心任务处理效率,Google专为AI训练设计的TPU(Tensor Processing Unit),通过脉动阵列架构优化矩阵乘法运算,算力可达GPU的2-3倍。

低功耗:数据中心是“能耗大户”,据IDC统计,全球数据中心能耗占全球总用电量的1%-2%,其中芯片功耗占比超60%,ASIC因无需支持通用指令,动态功耗和静态功耗显著降低,以网络处理ASIC为例,其功耗仅为同级别GPU的1/3-1/2,可有效降低数据中心的PUE(电源使用效率)和运营成本。

高性价比:尽管ASIC前期研发投入较高(通常需数千万美元级),但大规模量产后的单位成本远低于通用芯片,AWS自研的Trainium AI训练芯片,单芯片成本仅为同性能GPU的50%,且能效比提升3倍,帮助AWS将AI训练成本降低40%。

ASIC芯片在云计算中的典型应用场景

云计算场景的多样性决定了ASIC芯片需覆盖“云-边-端”全链条,不同场景对芯片的需求也各有侧重。

数据中心网络加速

云计算的分布式架构依赖高效的网络通信,传统网络处理器(NP)或CPU处理网络转发时,存在延迟高、占用CPU资源多的问题,网络处理ASIC(如SmartNIC/智能网卡)通过集成RDMA(远程直接内存访问)、DPU(数据处理器)等功能,将虚拟化、安全加密、流量调度等任务 offload 到硬件层面,释放CPU资源,阿里云自研的智能网卡C-Series,可支持400Gbps带宽,转发延迟低至50微秒,使虚拟机密度提升30%。

AI训练与推理加速

AI大模型(如GPT-4、PaLM)的训练需要万卡级并行算力,通用GPU虽能支持,但能效比不足,AI训练ASIC(如Google TPU v4、华为昇腾910B)针对张量运算优化,采用高带宽内存(HBM)和片上网络(NoC)架构,大幅提升计算效率,在推理场景,低功耗ASIC(如Google Edge TPU、寒武纪思元220)可部署在边缘节点,实现本地化实时推理,降低云端压力,百度Apollo自动驾驶平台采用边缘TPU,将障碍物检测延迟从100ms降至20ms。

存储系统加速

分布式存储(如Ceph、GlusterFS)依赖小文件随机读写、元数据处理等场景,对IOPS和延迟要求极高,存储控制ASIC(如NVMe SSD控制器)通过集成硬件压缩、去重、纠错码(ECC)功能,将SSD的IOPS从百万级提升至千万级,延迟降低至微秒级,浪潮信息自研的存储ASIC,使分布式存储系统性能提升5倍,容量密度提高40%。

边缘云计算赋能

边缘计算需在设备端或边缘节点实现低延迟、低功耗的本地处理,通用芯片难以满足功耗预算(lt;10W),边缘ASIC(如高通Cloud AI 100、地平线旭日3)通过异构集成(CPU+AI加速器+信号处理单元),在5W功耗下即可提供10 TOPS算力,支持智慧城市、工业物联网等场景的实时分析,海康威视边缘ASIC使智能摄像头的本地识别准确率提升至98%,同时功耗降低60%。

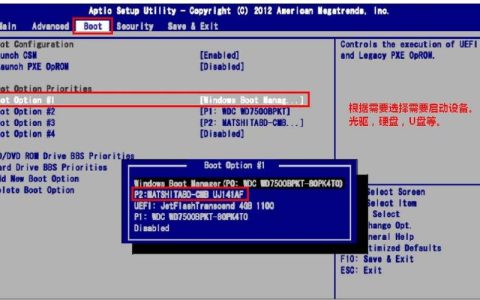

ASIC与通用芯片在云计算场景的关键指标对比

为更直观体现ASIC芯片的优势,以下通过表格对比其在云计算核心场景与通用芯片(CPU/GPU)的关键性能差异:

| 指标 | ASIC芯片(如TPU v4) | GPU(如NVIDIA A100) | CPU(如Intel Xeon Platinum 8380) |

|---|---|---|---|

| 算力(FP16) | 275 TOPS | 312 TOPS | 5 TOPS |

| 功耗 | 200W | 400W | 250W |

| 能效比(TOPS/W) | 375 | 78 | 002 |

| 单位算力成本(美元/TOPS) | 5 | 2 | 10 |

| 灵活性 | 低(仅支持特定算法) | 高(支持通用并行计算) | 高(支持全场景计算) |

| 典型应用场景 | AI训练、网络加速 | AI训练、科学计算 | 通用计算、虚拟化 |

ASIC芯片在云计算中面临的挑战与未来趋势

尽管ASIC芯片优势显著,但其发展仍面临三重挑战:一是研发门槛高,ASIC设计需从算法、架构到工艺的全链路协同,开发周期长达18-24个月,中小厂商难以承担;二是灵活性不足,ASIC一旦定型难以修改,难以适应云计算场景快速迭代的需求;三是生态碎片化,不同厂商的ASIC指令集、开发工具不兼容,增加开发者适配成本。

ASIC芯片将呈现三大发展趋势:

- Chiplet(芯粒)技术提升灵活性:通过将ASIC拆分为计算、存储、I/O等芯粒,采用先进封装(如CoWoS)实现“模块化集成”,既保留专用性,又支持灵活组合,缩短开发周期至6-12个月。

- 存算一体突破能效瓶颈:传统架构中数据需在存储与计算单元间频繁搬运,能耗占比超60%,存算一体ASIC将计算单元嵌入存储阵列,实现“存算融合”,能效比可再提升10倍以上。

- 云厂商深度定制与生态开放:头部云厂商(如AWS、阿里云)通过自研ASIC降低成本,同时开放开发平台(如AWS Trainium Neuron SDK),吸引开发者共建生态,缓解碎片化问题。

ASIC芯片凭借“专用化、高性能、低功耗”的特性,已成为云计算突破算力瓶颈的核心支撑,从数据中心网络加速到AI大模型训练,从边缘计算到存储优化,ASIC正在重塑云计算的算力底座,尽管面临灵活性、生态等挑战,但随着Chiplet、存算一体等技术的成熟,ASIC芯片将在能效、成本、场景适配性上持续突破,与CPU、GPU形成“通用+专用”的协同算力体系,推动云计算向更高效、更智能、更普惠的方向发展。

相关问答FAQs

问题1:为什么云计算厂商(如AWS、Google、阿里云)纷纷自研ASIC芯片?

解答:核心原因有三:一是成本优化,自研ASIC可针对自身云服务场景定制,单位算力成本比通用芯片低30%-50%,显著降低TCO(总拥有成本);二是性能领先,通过深度优化算法与硬件的协同,算力效率比通用芯片高2-3倍,提升服务竞争力;三是技术自主,减少对Intel、NVIDIA等通用芯片厂商的依赖,保障供应链安全,同时快速响应市场需求变化。

问题2:ASIC芯片的“不灵活性”是否会限制其在云计算中的应用?

解答:这一问题正通过技术创新逐步解决。Chiplet(芯粒)技术的兴起,将ASIC拆分为可复用的功能模块(如计算芯粒、存储芯粒),通过先进封装灵活组合,提升设计灵活性;云厂商正探索“可重构ASIC”,支持部分硬件逻辑动态调整,适应不同任务需求,针对长期稳定场景(如特定AI模型、网络协议),ASIC的专用性仍是优势,其能效和成本优势远超通用芯片,未来将长期与CPU/GPU形成互补,而非完全替代。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复