ASCII(American Standard Code for Information Interchange,美国信息交换标准代码)是计算机系统中最早广泛使用的字符编码标准之一,其核心作用是将文本字符(如字母、数字、标点符号和控制字符)转换为计算机能够识别和处理的二进制形式,作为一种基于拉丁字母的编码方案,ASCII通过为每个字符分配唯一的数值(码点),再将数值转换为二进制,实现了字符与二进制数据之间的映射,从而解决了文本信息在数字设备中的存储和传输问题。

ASCII的二进制存储基础

ASCII最初被设计为7位编码,这意味着它使用7个二进制位(bit)来表示一个字符,理论上可以表示2^7=128个不同字符,7位二进制数的范围是0000000(十进制0)到1111111(十进制127),每个7位组合对应一个唯一的字符,在计算机系统中,数据通常以字节(Byte)为单位进行处理,1字节等于8位,ASCII码在实际存储时,会在7位码的前面补1位最高位(Most Significant Bit, MSB),使其扩展为8位(1字节),补位规则通常是:对于标准ASCII字符(码点0-127),最高位固定补0,形成8位二进制形式,字符“A”的ASCII码为65(十进制),其7位二进制是1000001,存储时补最高位0后,实际二进制形式为01000001。

这种8位存储方式不仅符合计算机的字节处理逻辑,还为后续的编码扩展提供了可能,扩展ASCII(Extended ASCII)利用最高位(原本补0的位置)来表示额外的128个字符(码点128-255),从而支持更多符号(如带重音的拉丁字母、图形符号等),但扩展ASCII并未形成统一标准,不同系统(如DOS、Windows早期版本)的扩展ASCII编码可能存在差异。

ASCII码结构与字符分类

ASCII的128个字符可分为两大类:控制字符(Control Characters)和可打印字符(Printable Characters),控制字符主要用于控制设备(如打印机、终端)的输入输出操作,不直接显示为文本符号;可打印字符则是日常文本中可见的符号,包括数字、字母、标点符号等。

控制字符(码点0-31和127)

控制字符共33个,其中码点0-31为常用控制字符,码点127(DEL)为删除字符。

- 码点0:NUL(Null Character,空字符),用于表示字符串结束或填充无用数据;

- 码点10:LF(Line Feed,换行),使光标或打印头移动到下一行;

- 码点13:CR(Carriage Return,回车),使光标或打印头移动到当前行开头;

- 码点127:DEL(Delete,删除),用于删除前一个字符。

这些控制字符的二进制存储形式同样遵循8位规则,例如LF(码点10)的7位二进制为0001010,存储时补最高位0后为00001010。

可打印字符(码点32-126)

可打印字符共94个,是ASCII中最常用的部分,包括:

- 数字字符:0-9(码点48-57);

- 大写字母:A-Z(码点65-90);

- 小写字母:a-z(码点97-122);

- 标点符号与特殊符号:如空格(码点32)、!(码点33)、?(码点63)等。

为直观展示部分可打印字符的二进制存储形式,下表列出了常见字符的ASCII码点(十进制、十六进制)及8位二进制存储形式:

| 字符类别 | 字符示例 | 十进制码点 | 十六进制码点 | 8位二进制存储形式 |

|---|---|---|---|---|

| 数字 | 0 | 48 | 30 | 00110000 |

| 数字 | 5 | 53 | 35 | 00110101 |

| 数字 | 9 | 57 | 39 | 00111001 |

| 大写字母 | A | 65 | 41 | 01000001 |

| 大写字母 | F | 70 | 46 | 01000110 |

| 大写字母 | Z | 90 | 5A | 01011010 |

| 小写字母 | a | 97 | 61 | 01100001 |

| 小写字母 | f | 102 | 66 | 01100110 |

| 小写字母 | z | 122 | 7A | 01111010 |

| 标点符号 | (空格) | 32 | 20 | 00100000 |

| 标点符号 | 33 | 21 | 00100001 | |

| 标点符号 | 63 | 3F | 00111111 |

二进制存储的实现与应用

在计算机系统中,ASCII字符的二进制存储过程本质是“字符→码点→二进制”的转换,存储字符串“Hello”时,计算机会依次处理每个字符:

- 字符“H”:查ASCII表得码点72(十进制),转换为8位二进制01001000;

- 字符“e”:码点101,二进制01100101;

- 字符“l”:码点108,二进制01101100(重复两次);

- 字符“o”:码点111,二进制01101111。

字符串“Hello”在内存或磁盘中存储为5个连续的字节:01001000 01100101 01101100 01101100 01101111。

这种二进制存储形式的应用场景极为广泛。

- 文本文件存储:早期的.txt文件(如Windows记事本创建的ANSI编码文件)直接使用ASCII或扩展ASCII存储字符,每个字符占1字节;

- 网络通信:在HTTP协议、电子邮件等早期网络应用中,ASCII被用于传输控制信息(如请求头、邮件头),因其兼容性强,不同系统能正确解析;

- 设备控制:通过ASCII控制字符(如CR、LF)实现打印机换行、终端清屏等操作,是硬件设备与软件交互的基础。

ASCII的局限性与发展

尽管ASCII在计算机发展初期发挥了关键作用,但其7位编码的局限性也日益凸显:仅能支持128个字符,无法表示非拉丁字母(如中文、日文、阿拉伯文),甚至无法覆盖西欧语言中的特殊符号(如é、ü),为解决这一问题,后续出现了多种扩展编码:

- 扩展ASCII:利用最高位扩展至8位,支持256字符,但标准不统一;

- Unicode:如UTF-8编码,兼容ASCII(ASCII字符的UTF-8编码与ASCII完全相同),同时支持全球所有字符,成为当前主流编码方案。

尽管如此,ASCII的二进制存储形式仍是现代编码的基础,在UTF-8中,ASCII字符(码点0-127)仍使用1字节存储,且最高位为0,与标准ASCII完全一致,这保证了ASCII文本在UTF-8系统中的兼容性。

FAQs

Q1:ASCII码为什么是7位,但存储时常用8位?

A1:ASCII最初设计为7位编码,因为2^7=128个字符已满足当时英语环境下的基本需求(数字、字母、控制字符等),但计算机系统以字节(8位)为基本数据单位,若直接存储7位数据,会导致内存寻址和数据处理效率降低(需额外处理“非完整字节”),实际存储时在7位码前补1位最高位(通常补0),使其扩展为8位(1字节),既符合计算机的字节处理逻辑,又保留了与7位ASCII的兼容性,补出的最高位也为后续扩展ASCII(支持256字符)提供了可能。

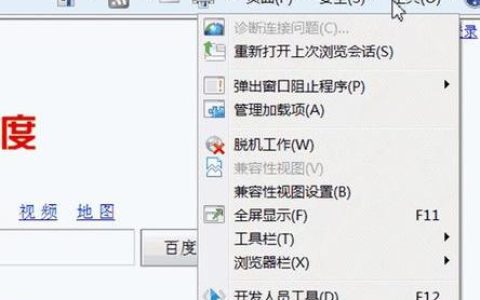

Q2:如何查看一个字符的ASCII二进制存储形式?

A2:可通过多种方式查看字符的ASCII二进制存储形式:

- 编程语言:以Python为例,使用

ord()函数获取字符的十进制码点,再用bin()函数转换为二进制(需注意bin()返回的是7位二进制字符串,需手动补最高位0至8位),查看字符“A”的二进制存储:char = 'A' decimal_code = ord(char) # 返回65 binary_7bit = bin(decimal_code) # 返回'0b1000001'(0b为二进制前缀) binary_8bit = binary_7bit[2:].zfill(8) # 去掉前缀并补0至8位,得'01000001' print(f"字符'{char}'的8位二进制存储形式为:{binary_8bit}") - 在线工具:通过搜索“ASCII码转换工具”,输入字符后可直接查看其十进制、十六进制和二进制形式(通常显示8位二进制);

- 系统工具:在Linux/macOS终端中,可使用

man ascii命令查看完整ASCII表,包含字符的十进制、十六进制和二进制(八进制)形式。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复