AR(增强现实)技术通过将虚拟信息叠加至现实场景,正深刻改变工业制造、消费娱乐、医疗健康等领域的交互方式,实时图像识别是AR体验的核心基础,需快速捕捉并分析环境中的物体、场景或特征,以触发相应的虚拟内容加载,随着深度学习模型复杂度提升(如参数量达GB级的Transformer模型),本地设备(如手机、AR眼镜)的算力与存储空间逐渐难以满足需求,将识别图模型部署在远程服务器(云端或边缘端)成为突破硬件限制的主流方案,这种“端-边-云”协同架构不仅释放了模型性能潜力,还能通过集中化部署实现动态更新、资源弹性调度和跨设备数据共享,为AR应用的高效运行提供底层支撑。

架构与核心组件

AR云识别的系统架构通常分为三层:前端感知层、网络传输层和服务计算层,前端感知层由AR设备(如智能手机、AR眼镜)构成,负责采集实时图像/视频流,经预处理(去噪、分辨率调整、格式转换)后,通过网络传输层发送至服务器,网络传输层需保障低延迟、高带宽,通常结合5G、Wi-Fi 6等高速无线技术,并依托边缘计算节点实现“就近接入”,减少数据传输距离,服务计算层是核心,包含云服务器或边缘服务器,负责接收前端数据,调用预训练的识别图模型进行推理,并将识别结果(如物体位置、类别、3D姿态)返回至前端,驱动AR内容的渲染与叠加。

这种架构的核心优势在于“分工协同”:前端设备专注感知与交互,服务器负责复杂计算,两者通过高效网络连接,形成“采集-传输-推理-反馈”的闭环,在工业AR场景中,工人通过AR眼镜拍摄设备部件,边缘服务器快速识别型号后,云端再调取详细维修手册并叠加至视野,实现“毫秒级响应+精准信息匹配”。

关键技术支撑

模型轻量化与优化

部署在服务器的识别模型虽无需本地适配,但仍需优化推理效率,通过模型剪枝(去除冗余神经元)、量化(将浮点参数转为8位整点)、知识蒸馏(用大模型指导小模型训练)等技术,可在保持精度的同时大幅压缩模型体积,MobileNetV3-Small模型在ImageNet上的精度与ResNet50接近,但参数量仅为其1/50,推理速度提升3倍以上,适合云识别场景,ONNX(Open Neural Network Exchange)格式可实现模型跨平台部署,避免框架转换带来的性能损耗。

边缘与云协同计算

根据实时性需求分层处理是关键:边缘服务器部署轻量级模型(如YOLOv5n),处理低延迟任务(如快速检测常见物体);云端服务器部署复杂模型(如Mask R-CNN、PointNet++),处理高精度需求(如细粒度分类、3D重建),当边缘节点无法识别时,再将数据上传至云端,形成“边缘初审-云端终审”的流水线,在商场AR导航中,边缘服务器快速识别“店铺招牌”,云端则根据用户位置生成最优路径,平衡延迟与精度。

网络传输优化

AR图像数据量大(4K视频每帧约8MB),需通过协议优化与数据压缩减少传输开销,QUIC协议替代传统TCP,减少三次握手延迟;动态码率调整(根据网络状况切换720P/1080P)降低带宽占用;边缘缓存(存储常用物体识别结果)避免重复传输,CDN节点可预加载“商品”“地标”等高频识别模型,使前端设备就近获取,响应时间从200ms降至50ms以内。

实时性与高并发保障

AR应用要求端到端延迟低于50ms(人眼可感知阈值),需通过服务器集群负载均衡、GPU并行推理(TensorRT加速)和异步处理实现高并发,大型展会中,边缘服务器集群可同时处理数千设备请求,通过Kubernetes自动扩缩容,应对峰值流量;异步消息队列(如RabbitMQ)解耦数据传输,避免前端因等待超时卡顿。

安全与隐私保护

图像数据包含用户环境信息,需在传输(TLS 1.3加密)、存储(AES-256加密)全流程保护隐私,服务器端采用差分隐私(添加噪声保护原始数据),模型参数通过联邦学习更新(不共享原始数据),防止敏感信息泄露,医疗AR中,患者影像数据仅在服务器端脱敏处理,医生仅接收识别后的病灶标注,不接触原始图像。

应用场景落地

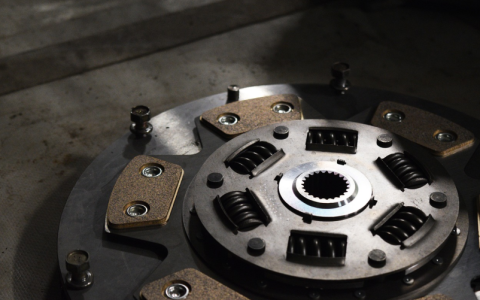

- 工业AR:工厂设备维护时,工人通过AR眼镜拍摄故障部件,云端服务器识别型号后,叠加维修步骤、零件库存信息,缩短停机时间30%以上。

- 消费级AR:商场购物时,手机扫描商品,云端识别后展示虚拟试穿、用户评价,转化率提升25%。

- 医疗AR:医生通过AR眼镜观察患者器官,云端结合CT影像识别病灶位置,误差低于0.5mm,辅助精准手术。

- 教育AR:学生用平板扫描课本,云端识别知识点后加载3D实验模型,抽象概念具象化,学习效率提升40%。

挑战与解决方案

| 挑战 | 解决方案 |

|---|---|

| 延迟波动 | 边缘节点下沉+预测模型(预判用户操作,提前加载模型);UDP+重传机制快速恢复丢包 |

| 模型同步滞后 | 长连接推送(WebSocket)实时通知更新;增量更新(仅传输修改参数,减少下载量) |

| 成本控制 | Serverless架构(按需付费,自动扩缩容);闲时迁移任务至低成本服务器 |

| 多设备协同 | 云端统一管理设备状态与识别历史;消息队列同步数据,支持多人AR协作场景 |

本地部署vs服务器部署对比

| 维度 | 本地部署 | 服务器部署(云端/边缘) |

|---|---|---|

| 算力需求 | 依赖设备GPU,性能受限 | 依托服务器GPU集群,算力充足 |

| 模型更新 | 需手动更新,灵活性低 | 远程推送更新,实时生效 |

| 延迟 | 本地推理延迟低(<30ms) | 依赖网络,边缘端50-100ms,云端100-200ms |

| 成本 | 无需服务器成本 | 需支付服务器、带宽费用,但可共享资源 |

| 多设备协同 | 难以实现数据共享 | 支持跨设备数据同步与协同识别 |

| 适用场景 | 简单识别、离线场景 | 复杂模型、实时更新、多用户并发 |

FAQs

AR云识别图模型部署在云端服务器相比本地部署有哪些核心优势?

答:核心优势包括:①算力突破:服务器GPU集群可运行超大规模模型(如ViT、GPT-4V),本地设备难以支持;②动态更新:模型迭代无需用户手动升级,远程推送即可生效;③资源复用:多设备共享服务器资源,降低单用户成本;④协同能力:支持跨设备数据共享(如多人AR协作场景),本地部署无法实现;⑤安全可控:模型和数据集中在服务器端,便于权限管理和漏洞修复。

如何解决AR云识别中因网络波动导致的识别延迟或中断问题?

答:可通过以下方案解决:①边缘计算下沉:在用户密集区域(如商场、工厂)部署边缘服务器,减少数据传输距离;②智能缓存机制:缓存常用识别结果和模型片段,网络波动时优先返回缓存数据;③自适应传输协议:采用UDP+重传机制(如QUIC协议),在丢包时快速恢复;④模型轻量化与分级:将模型拆分为基础层(边缘端运行)和增强层(云端运行),网络差时仅使用基础层保证基础识别;⑤冗余链路:同时连接Wi-Fi和5G,一条链路中断时自动切换至另一条。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复