在探讨“怎么爬取网站的数据库”这一话题时,首先需要明确一个核心概念:通常情况下,我们并不能直接访问和爬取一个网站的数据库本身,数据库位于网站服务器的内部,受到防火墙和安全协议的严格保护,我们所说的“爬取”,实际上是指模拟浏览器的行为,获取网站服务器发送给前端展示的HTML页面数据,或是通过分析其内部调用的API接口来获取结构化数据,这个过程本质上是对公开可见信息的批量采集,而非对后台数据库的直接入侵。

理解网络爬虫的基本原理

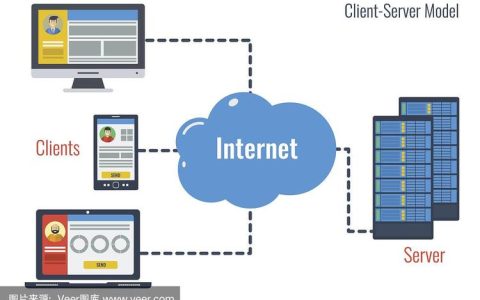

网络爬虫,也常被称为网络蜘蛛,是一个自动化程序,其工作流程遵循着“请求-响应-解析-提取”的基本模式,当您在浏览器地址栏输入一个网址并回车时,您的浏览器就向该网站的服务器发送了一个HTTP请求,服务器接收到请求后,会返回相应的HTML、CSS、JavaScript等文件,浏览器再将这些文件渲染成您看到的丰富多彩的网页,爬虫所做的工作,就是用代码来模拟这个过程,但它只关心包含数据的HTML内容或API返回的JSON数据,而不进行视觉渲染。

爬取网站数据的完整步骤

一个完整的数据爬取项目通常包含以下几个关键环节:

目标分析与工具准备

在开始编写代码前,首要任务是分析目标网站,您需要打开浏览器的开发者工具(通常按F12键),仔细观察网页的结构。

- 静态网站:数据直接嵌入在HTML源码中,当您查看网页源代码时,能看到所有需要的信息。

- 动态网站:页面初始加载时可能只有框架,真实数据是通过后续的JavaScript执行,向服务器发起API请求(通常在开发者工具的“网络”面板中能看到XHR或Fetch请求)后,再填充到页面中的。

根据网站类型,选择合适的工具,Python是爬虫领域最主流的语言,其生态丰富,库函数强大。

| 工具类型 | 适用场景 | 代表库 | 优点 | 缺点 |

|---|---|---|---|---|

| HTTP请求库 | 静态网站、API接口调用 | Requests | 轻量、高效、简单易用 | 无法处理JavaScript渲染的动态内容 |

| 浏览器自动化 | 动态网站、复杂交互 | Selenium, Playwright | 能模拟真实用户操作,支持JS渲染 | 资源消耗大,速度相对较慢 |

| HTML解析库 | 解析提取HTML数据 | BeautifulSoup, lxml | 语法简洁,定位元素方便 | 本身不负责请求和渲染 |

发送HTTP请求

使用如Requests库,向目标URL发送一个GET请求,为了模拟真实用户、避免被反爬虫机制识别,通常需要设置请求头,尤其是User-Agent字段,它告诉服务器“我是一个什么类型的浏览器”。

解析页面内容

获取到服务器返回的HTML内容后,就需要使用解析库来提取数据。BeautifulSoup是一个非常受欢迎的选择,它将复杂的HTML文档转换成一个树形结构,您可以通过标签名、类名、ID等轻松地定位到所需的数据节点。

数据提取与清洗

定位到数据节点后,使用.text或.get('attribute')等方法提取出纯文本或属性值,原始数据往往包含多余的空格、换行符或无关字符,需要进行清洗和格式化,使其变得规整可用。

数据存储

将清洗好的数据保存到本地文件或数据库中,常见的存储格式有CSV(适合表格数据)、JSON(适合结构化数据)以及直接存入SQLite、MySQL等数据库,以便后续分析和查询。

法律与道德边界

在探讨技术实现的同时,必须强调法律与道德的约束,在进行任何爬取活动前,请务必:

- 检查

robots.txt文件:这是网站根目录下的一个君子协定,规定了哪些路径不允许爬虫访问。 - 遵守服务条款:许多网站的用户协议中明确禁止或限制数据爬取。

- 控制请求频率:过于频繁的请求会对目标网站服务器造成巨大压力,可能导致其服务中断,应设置合理的延迟,做一个“友好”的爬虫。

- 尊重数据版权与隐私:不爬取和传播受版权保护的内容或个人隐私信息。

学习怎么爬取网站的数据库,实际上是学习如何合法、合规、高效地获取公开网络数据的过程,它是一项强大的技能,但必须以负责任的态度来使用。

相关问答FAQs

Q1:爬虫和直接调用API有什么区别?我应该优先选择哪种方式?

A1: 主要区别在于获取数据的方式和官方性,API(应用程序编程接口)是网站官方提供的数据交换通道,通常返回结构化的JSON或XML数据,稳定、高效且明确,而爬虫是模拟用户行为,从HTML页面中“抠”数据,是非官方的,一旦页面改版,爬虫就可能失效。优先选择API,如果网站提供了公开API,这无疑是最佳选择,只有在没有API或API功能受限时,才考虑使用爬虫技术。

Q2:我的爬虫程序运行一小段时间后,IP地址就被网站封禁了,该如何解决?

A2: IP被封禁是网站最常见的反爬虫策略,解决方案主要有:

- 降低请求频率:在请求之间加入随机的时间延迟(如

time.sleep(random.uniform(1, 3))),模拟人类浏览行为。 - 轮换User-Agent:准备一个User-Agent列表,每次请求随机选择一个,让服务器误以为是不同的浏览器在访问。

- 使用代理IP:通过购买或搭建代理IP池,让每次请求都通过不同的IP地址发出,这是对抗IP封禁最有效的方法。

- 使用无头浏览器:像Selenium或Playwright这样的工具能更好地模拟真实浏览器,有时可以绕过一些简单的反爬检测。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复