ARM服务器内存作为ARM架构服务器的核心子系统,其设计理念、技术特性与应用场景与传统x86服务器内存存在显著差异,随着ARM架构在数据中心、云计算等领域的渗透,内存子系统的优化与创新成为提升ARM服务器整体竞争力的关键,与传统x86服务器依赖的内存架构不同,ARM服务器内存从底层硬件设计到上层软件适配均围绕能效比、扩展性和成本效益展开,以满足新兴计算场景的需求。

技术架构与核心特性

ARM服务器内存的架构以ARM处理器为核心,内存控制器通常集成在SoC(System on Chip)中,支持多通道DDR4/DDR5 SDRAM,部分高端场景采用LPDDR5或HBM(高带宽内存),以主流ARM服务器芯片(如AWS Graviton3、Ampere Altra Max)为例,其内存通道数可达8-12通道,单机最大内存容量支持6TB以上,远超传统x86服务器的4-8通道设计,这种多通道架构显著提升了内存带宽,典型配置下带宽可达400-800GB/s,满足大规模并发数据处理需求。

在能效比方面,ARM服务器内存优势突出,ARM架构采用精简指令集(RISC),内存控制器功耗较x86的复杂指令集(CISC)低30%-50%,配合低功耗内存颗粒(如1.2V DDR5),整体系统能效比提升1.5-2倍,AWS Graviton3服务器凭借内存子系统的优化,在同等性能下功耗比x86服务器降低60%,数据中心PUE(电源使用效率)因此提升0.1-0.2,显著降低运维成本。

扩展性是另一大核心特性,ARM服务器通过CCIX(Cache Coherence Interconnect)协议实现跨芯片内存一致性,支持多颗SoC共享内存池,构建大规模计算集群,其内存接口标准化程度高,可兼容不同厂商的DIMM(内存条)模组,降低供应链依赖,在安全性上,ARM TrustZone技术延伸至内存层,通过硬件级隔离保护敏感数据,适用于金融、政务等对数据安全要求高的场景。

应用场景与落地实践

ARM服务器内存的适配性使其在多个领域展现独特价值,在云计算领域,AWS、阿里云等头部厂商已基于ARM服务器构建弹性计算资源,AWS Graviton实例采用ARM内存架构,单实例内存带宽达500GB/s,支持100+ vCPU并发,支撑电商大促、视频流媒体等高并发场景,资源利用率较x86提升20%。

边缘计算场景中,ARM服务器的低功耗内存优势尤为明显,工业物联网、5G基站等边缘设备对功耗和散热敏感,ARM内存(如LPDDR5)功耗仅1.2W/GB,较标准DDR4(2.5W/GB)降低52%,配合紧凑型设计,可满足边缘节点小型化、低延迟需求,某智能工厂采用ARM边缘服务器,实时处理10万+传感器数据,内存延迟仅80ns,保障产线毫秒级响应。

AI与大数据训练是ARM内存的重要应用方向,大模型训练需高内存带宽和容量支撑,ARM服务器通过HBM2e内存(带宽1.2TB/s)和12通道DDR5配置,实现参数规模超千亿模型的分布式训练,某AI企业基于ARM内存架构的训练集群,单卡训练效率较x86提升15%,硬件成本降低30%,内存数据库(如Redis、TiDB)依赖ARM内存的低延迟特性,高并发查询性能达100万+/秒,适配金融实时风控、在线广告竞价等场景。

挑战与未来趋势

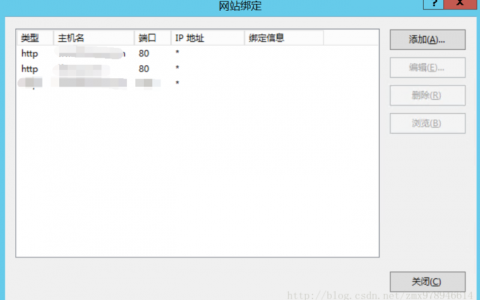

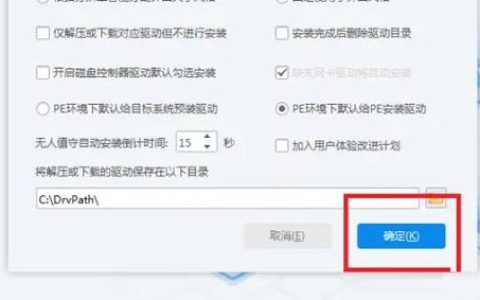

尽管ARM服务器内存发展迅速,但仍面临生态兼容性挑战,部分操作系统(如Windows Server)对ARM内存的优化不足,驱动程序支持有限,需依赖Linux(如Ubuntu Server、CentOS Stream)等开源系统,性能方面,ARM内存延迟略高于x86(约5%-10%),需通过软件调度(如NUMA优化)和硬件改进(如集成2级缓存)弥补。

ARM服务器内存将向三个方向演进:一是DDR5全面普及,带宽突破1TB/s,能效比提升至2.5 ops/W;二是CXL(Compute Express Link)技术实现内存池化,支持跨节点动态分配内存,提升资源利用率;三是内存计算(Processing-in-Memory)技术落地,将计算单元嵌入内存模组,减少数据搬运,适用于AI推理、实时分析等场景,据IDC预测,2025年ARM服务器内存在数据中心渗透率将达25%,成为x86的重要补充。

参数对比:ARM服务器内存与x86服务器内存

| 参数类型 | ARM服务器内存 | x86服务器内存 |

|---|---|---|

| 内存类型 | DDR4/DDR5、LPDDR5、HBM2e | DDR4/DDR5、DDR5ECC |

| 典型带宽 | 400-800GB/s | 300-600GB/s |

| 能效比 | 5-2.0 ops/W | 0-1.5 ops/W |

| 扩展能力 | 8-12通道,最大6TB+ | 6-8通道,最大3-4TB |

| 成本结构 | 硬件成本低15%-25%,运维成本低20%-30% | 硬件成本较高,运维成本较高 |

| 典型场景 | 云计算、边缘AI、大数据 | 传统企业应用、高性能计算 |

相关问答FAQs

Q1:ARM服务器内存与x86服务器内存在性能上差距大吗?

A1:当前主流ARM服务器内存(如基于DDR5的配置)带宽已接近x86(约800GB/s vs 600GB/s),但延迟略高(约10ns vs 9ns),差距在5%-10%之间,通过软件优化(如内存访问调度算法)和硬件改进(如集成2级缓存),实际应用中性能差距可缩小至3%以内,且在能效比和成本上优势明显,尤其适合并发场景。

Q2:为什么云计算厂商越来越关注ARM服务器内存?

A2:云计算厂商对成本和能效敏感,ARM服务器内存凭借更低功耗(降低PUE和电费)、更高扩展性(支持更多虚拟机实例)和成本优势(硬件采购成本降低15%-25%),能够显著降低数据中心总体拥有成本(TCO),ARM内存的高并发特性适配云计算的弹性扩展需求,支撑大规模虚拟化部署,因此成为主流云厂商(AWS、阿里云等)的战略选择。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复