在数据处理工作中,我们经常遇到一个看似简单却颇具挑战性的任务:如何将一个CSV文件中的单行数据,有效地拆分并存储到关系型数据库的多张表中,形成多行关联记录,这个过程本质上是从非结构化或半结构化的平面数据向结构化的关系型数据的转换,其核心在于数据库设计中的“规范化”思想,本文将深入探讨这一过程的原理、实现方法以及最佳实践。

理解问题的本质:为何需要拆分?

我们需要明白为什么会有这样的需求,CSV文件以其简洁、通用的特性,成为数据交换的首选格式,它的二维表格结构天然倾向于“反规范化”,即为了方便查看,将所有相关信息都塞进一行。

想象一个订单CSV文件,它可能长这样:

OrderID,CustomerName,CustomerEmail,OrderDate,ProductID_1,ProductName_1,Quantity_1,ProductID_2,ProductName_2,Quantity_2

1001,张三,zhangsan@email.com,2025-10-27,P001,笔记本电脑,1,P003,无线鼠标,1

1002,李四,lisi@email.com,2025-10-27,P002,机械键盘,2,,观察第一行数据,它包含了客户信息(张三)、订单信息(1001号订单)以及两个商品信息,如果直接将这一行存入数据库的一张表,会产生严重的问题:

- 数据冗余:如果张三下了100个订单,他的姓名和邮箱就会被重复存储100次。

- 数据不一致风险:某次录入时,张三的邮箱可能被写错,导致同一个客户对应多个不同的邮箱,数据管理变得混乱。

- 更新异常:如果张三更改了邮箱,你需要更新100条记录,极易遗漏。

- 删除异常:如果删除了张三的唯一一个订单,那么张三的客户信息也随之丢失了。

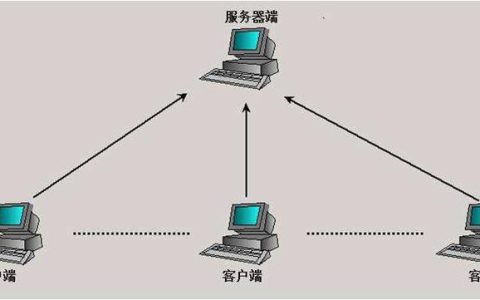

为了解决这些问题,关系型数据库设计引入了规范化理论,上述订单数据,在一个设计良好的数据库中,应该被拆分为至少三张表:Customers(客户表)、Orders(订单表)和 Order_Items(订单商品明细表)。

设计目标数据库结构

在动手编写转换脚本之前,必须先设计好目标数据库的结构,以上述订单数据为例,一个规范化的结构如下:

Customers 表 (客户表)

| 字段名 | 类型 | 描述 |

| :— | :— | :— |

| CustomerID | INT (主键) | 客户唯一标识 |

| CustomerName | VARCHAR(50) | 客户姓名 |

| CustomerEmail | VARCHAR(100) | 客户邮箱 |

| 字段名 | 类型 | 描述 |

| :— | :— | :— |

| OrderID | INT (主键) | 订单唯一标识 |

| CustomerID | INT (外键) | 关联到Customers表 |

| OrderDate | DATE | 下单日期 |

| 字段名 | 类型 | 描述 |

| :— | :— | :— |

| ItemID | INT (主键) | 明细项唯一标识 |

| OrderID | INT (外键) | 关联到Orders表 |

| ProductID | VARCHAR(20) | 商品ID |

| ProductName | VARCHAR(100) | 商品名称 |

| Quantity | INT | 购买数量 |

通过这样的设计,每种信息都各得其所,通过主键和外键建立起清晰的关联关系,彻底解决了冗余和不一致的问题。

实现转换:从CSV到多行数据库的核心逻辑

转换过程的核心是编写一个脚本(如Python、Perl、Shell等),逐行读取CSV文件,解析数据,然后按照预设的数据库结构执行插入操作,以下是使用Python和内置的sqlite3库的一个示例逻辑。

步骤1:读取与解析

脚本会打开CSV文件,使用csv模块逐行读取,对于每一行,它首先提取出客户信息(CustomerName, CustomerEmail)和订单信息(OrderID, OrderDate)。

步骤2:处理客户数据

检查Customers表中是否已存在该客户(通过邮箱或姓名查询),如果不存在,则执行INSERT操作将新客户信息存入Customers表,并获取新插入的CustomerID,如果已存在,则直接获取其CustomerID。

步骤3:处理订单数据

使用上一步获取的CustomerID和当前行的订单信息,向Orders表中插入一条新记录,同样,获取新插入的OrderID。

步骤4:循环处理商品明细

这是将“一行变多行”的关键,脚本需要遍历该行中所有的商品列(ProductID_1, ProductName_1, Quantity_1, ProductID_2, …),对于每一个非空的商品组合,都使用步骤3中获取的OrderID,向Order_Items表中插入一条新记录,如果一行有3个商品,这里就会插入3条记录。

Python代码示例片段:

import csv

import sqlite3

# 连接到SQLite数据库(如果不存在则会创建)

conn = sqlite3.connect('orders.db')

cursor = conn.cursor()

# (此处省略创建表的SQL语句,假设表已存在)

with open('orders.csv', mode='r', encoding='utf-8') as csvfile:

reader = csv.DictReader(csvfile)

for row in reader:

# 1. 处理客户

cursor.execute("SELECT CustomerID FROM Customers WHERE CustomerEmail = ?", (row['CustomerEmail'],))

customer = cursor.fetchone()

if not customer:

cursor.execute("INSERT INTO Customers (CustomerName, CustomerEmail) VALUES (?, ?)",

(row['CustomerName'], row['CustomerEmail']))

customer_id = cursor.lastrowid

else:

customer_id = customer[0]

# 2. 处理订单

cursor.execute("INSERT INTO Orders (OrderID, CustomerID, OrderDate) VALUES (?, ?, ?)",

(row['OrderID'], customer_id, row['OrderDate']))

# 3. 循环处理商品明细

item_index = 1

while True:

product_id_key = f'ProductID_{item_index}'

if product_id_key in row and row[product_id_key]:

cursor.execute(

"INSERT INTO Order_Items (OrderID, ProductID, ProductName, Quantity) VALUES (?, ?, ?, ?)",

(row['OrderID'], row[product_id_key], row[f'ProductName_{item_index}'], row[f'Quantity_{item_index}'])

)

item_index += 1

else:

break # 遇到空商品则停止

# 提交事务并关闭连接

conn.commit()

conn.close() 最佳实践与注意事项

- 事务处理:将处理每一行CSV数据的所有数据库操作(插入客户、订单、多个商品明细)包裹在一个事务中,这意味着,如果其中任何一个步骤失败(插入第二个商品时出错),那么这一行对应的所有已执行操作都将被回滚,从而保证了数据的原子性和一致性,避免产生“半残”的数据。

- 错误处理与日志:健壮的脚本应具备完善的错误处理机制,当某行数据格式错误或无法插入时,应记录错误信息(如行号、错误原因)到日志文件,然后继续处理下一行,而不是让整个程序崩溃。

- 性能优化:对于数百万行的大型CSV文件,逐行插入会非常慢,可以考虑使用批量插入(

executemany)的方式,先将解析好的数据在内存中累积到一定数量(如1000条),然后一次性发送给数据库,可以极大提升性能。 - 数据清洗:在插入数据库前,对数据进行清洗是至关重要的一步,去除字符串前后多余的空格、统一日期格式、验证邮箱格式等,可以保证入库数据的质量。

将CSV的一行数据转换为数据库的多行记录,是一个结合了数据建模、编程逻辑和数据库操作的综合任务,其核心在于理解并应用数据库规范化思想,通过编写可靠的脚本,在保证数据完整性和一致性的前提下,高效地完成数据迁移和整合工作。

相关问答FAQs

问题1:如果我的CSV文件中,每一行包含的商品数量是不固定的,有些行有2个商品,有些有5个,甚至更多,该如何处理?

解答: 这是一个非常常见的情况,上述示例代码其实已经提供了一种解决方案:通过循环检测列名(如ProductID_1, ProductID_2…)是否存在且非空来动态处理,如果列名不规律,或者商品信息被压缩在单个单元格中(例如用分号分隔),则需要更复杂的解析逻辑,对于后者,你可以先读取该单元格的字符串,然后使用字符串的split()方法(按分号等分隔符)将其拆分成一个列表,再遍历这个列表来处理每个商品,关键在于你的解析逻辑需要足够灵活,能够适应这种可变性,而不是写死只能处理固定数量的商品。

问题2:对于包含数百万行数据的大型CSV文件,使用Python逐行处理脚本太慢了,有什么更高效的方案吗?

解答: 当数据量巨大时,性能确实会成为瓶颈,有以下几种优化策略:

- 批量插入:如前文所述,放弃逐行

INSERT,改为在内存中收集一批数据(例如5000条订单明细),然后使用数据库驱动的executemany()方法一次性执行,这能显著减少网络往返和数据库开销。 - 使用数据库专用加载工具:许多数据库都提供了高速导入数据的命令行工具,如MySQL的

LOAD DATA INFILE或PostgreSQL的COPY,这些工具通常比通过应用程序插入快几个数量级,你可以编写一个预处理脚本,将原始CSV拆分成多个符合目标表结构的、更小的CSV文件,然后分别用这些工具导入。 - 调整数据库配置:在执行大规模导入时,可以临时调整数据库的一些配置以提升写入性能,例如禁用索引、关闭外键检查、增大

innodb_buffer_pool_size等,导入完成后再重新启用这些功能。 - 并行处理:如果CPU和I/O资源允许,可以将大CSV文件分割成多个小文件,然后用多个进程或线程并行处理这些小文件,最后将结果汇总到数据库中,这可以充分利用多核服务器的计算能力。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复