在开发和管理网络爬虫项目时,实时或定期了解已经成功抓取并存储到数据库中的数据量,是一项至关重要的任务,这不仅有助于我们监控爬虫的运行状态、评估抓取效率,还能在出现问题时快速定位数据不一致的原因,本文将系统地介绍几种查看爬虫已抓取数据库记录数量的常用方法,从最直接的数据库查询到利用爬虫框架的内置功能,并探讨在不同场景下的最佳实践。

直接查询数据库:最权威的方法

这是最直接、最准确的方法,其核心思想是绕过爬虫本身,直接向数据库发起查询以获取表中的记录总数,这种方法的结果是最终的、权威的,因为它反映了数据库中实际存储的数据。

关系型数据库 (SQL)

对于MySQL、PostgreSQL、SQLite等关系型数据库,我们可以使用标准的SQL COUNT()聚合函数来统计记录数。

- 统计所有记录:

COUNT(*)会计算表中所有的行,包括包含NULL值的行。SELECT COUNT(*) FROM your_table_name;

- 统计非空记录:

COUNT(column_name)只会计算指定列中值不为NULL的行。SELECT COUNT(id) FROM your_table_name;

- 统计唯一记录数:如果数据存在重复,而你只想知道不重复的记录有多少条,可以使用

COUNT(DISTINCT column_name),这在需要根据唯一标识(如商品ID、文章URL)去重统计时非常有用。SELECT COUNT(DISTINCT unique_id) FROM your_table_name;

非关系型数据库

对于MongoDB、Redis等NoSQL数据库,同样有相应的命令来统计集合或键的数量。

- MongoDB:可以使用

countDocuments()或count()方法(后者已不推荐使用)。// 统计集合中所有文档的数量 db.your_collection_name.countDocuments({}); - Redis:如果使用列表(List)或集合(Set)存储数据,可以使用

LLEN或SCARD命令。LLEN your_list_name SCARD your_set_name

优点:结果绝对准确,是数据校验的最终标准。

缺点:需要具备数据库的访问权限和查询工具;对于数据量巨大的表(亿级别),COUNT(*) 操作可能会非常耗时,甚至对数据库性能造成影响。

利用爬虫框架的内置统计功能

许多成熟的爬虫框架,如Scrapy,都内置了强大的统计收集功能,它们会在爬虫运行过程中和结束后,自动收集并展示一系列关键指标。

以Scrapy为例,当爬虫任务完成后,它会在终端日志中打印一份详细的统计报告。item_scraped_count 这个字段就表示“已爬取的Item数量”。

2025-10-27 10:30:00 [scrapy.core.engine] INFO: Spider closed (finished)

2025-10-27 10:30:00 [scrapy.extensions.logstats] INFO: Crawled 1250 pages (at 125 pages/min), scraped 1200 items (at 120 items/min)

2025-10-27 10:30:00 [scrapy.statscollectors] INFO: Dumping Scrapy stats:

{

'downloader/request_count': 1250,

'downloader/response_count': 1250,

'item_scraped_count': 1200, <-- 这就是我们关心的数字

'log_count/DEBUG': 2451,

'log_count/INFO': 10,

'finish_reason': 'finished',

'finish_time': datetime.datetime(2025, 10, 27, 10, 30, 0, 123456)

}优点:无需额外操作,框架自动完成;可以实时了解爬取进度。

缺点:item_scraped_count 统计的是被爬虫成功“产出”的Item数量,并不完全等同于成功存入数据库的数量,如果数据在存储管道中发生错误(如数据库连接中断、数据格式不匹配等),这个数字可能与数据库中的实际记录数不符。

在数据管道中自定义日志记录

为了获得最接近实时且与数据库操作紧密相关的计数,最佳实践是在负责写入数据库的代码(通常是Scrapy中的Pipeline)中添加自定义日志。

这种方法通过在每次成功向数据库插入一条记录后,打印一条日志或更新一个计数器来实现。

以下是一个简化的Scrapy Pipeline示例:

import logging

class DatabasePipeline:

def __init__(self):

self.logger = logging.getLogger(__name__)

# 可以添加一个计数器

self.item_count = 0

def open_spider(self, spider):

# 爬虫启动时可以执行一些初始化操作,比如连接数据库

self.logger.info("数据库管道已开启,准备写入数据。")

# 可以从数据库查询当前数量作为起始点

# self.item_count = self.get_current_count_from_db()

def process_item(self, item, spider):

try:

# 这里是具体的数据库插入逻辑

# self.db.insert(item)

# 插入成功后,更新计数并记录日志

self.item_count += 1

self.logger.info(f"成功写入第 {self.item_count} 条数据: {item.get('name')}")

except Exception as e:

# 捕获并记录插入失败的错误

self.logger.error(f"数据写入失败: {item}, 错误: {e}")

# 可以选择将失败的item放入另一个队列进行重试

return item

def close_spider(self, spider):

# 爬虫结束时,可以输出最终的统计总数

self.logger.info(f"爬虫任务结束,本次共成功写入 {self.item_count} 条新数据。")

# 关闭数据库连接等 优点:实时反馈,精确到每一条记录的写入状态;便于调试,能快速定位是哪条数据写入失败。

缺点:需要编写额外的代码;如果数据量极大,高频的日志输出可能会对性能产生微小影响,并产生大量的日志文件。

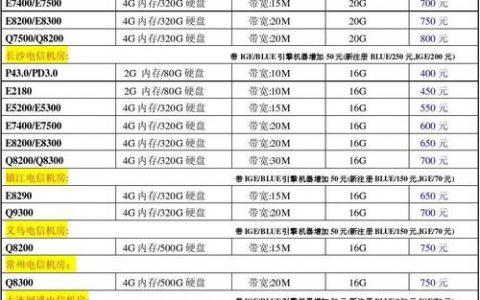

方法对比与选择

为了更清晰地选择合适的方法,我们可以将上述三种方法进行对比。

| 方法 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 直接查询数据库 | 结果绝对权威,是数据校验的黄金标准。 | 可能很慢(大表);需要数据库访问权限。 | 项目结束后的最终数据核对、定期数据审计。 |

| 框架内置统计 | 自动化,无需编码,可监控整体进度。 | 统计的是“产出”而非“存储”,可能存在误差。 | 爬虫运行期间的快速进度概览,非精确要求下的监控。 |

| 自定义日志记录 | 实时性强,精确反馈存储状态,便于调试。 | 需要额外编码,可能产生大量日志。 | 开发和调试阶段,需要精确追踪数据写入过程的场景。 |

在实际工作中,最佳策略通常是组合使用:在开发阶段,通过自定义日志记录来确保数据流的顺畅和准确;在爬虫日常运行时,观察框架内置统计来掌握大致进度;在需要生成报告或进行数据校验时,使用直接查询数据库来获得最终的确切数字。

相关问答 (FAQs)

为什么我的爬虫日志显示爬取了1000条数据,但数据库里只有980条?

答:这是一个常见问题,通常由以下几个原因造成:

- 数据写入失败:在数据通过Pipeline写入数据库的过程中,可能因为网络瞬断、数据库约束冲突(如唯一键重复)、数据格式不符合要求等原因导致部分数据插入失败,如果你的Pipeline有完善的异常处理,这些失败的条目会被记录在错误日志中。

- 去重机制:你的爬虫可能设置了去重逻辑,当爬取到重复的数据时,Scrapy的

item_scraped_count可能仍然会增加(取决于你的去重实现位置),但在写入数据库前,数据被判断为重复并被丢弃,因此不会新增记录。 - 事务回滚:在某些情况下,如果数据库操作被包裹在一个事务中,并且事务中某一步操作失败,整个事务可能会回滚,导致本批次已插入的数据全部被撤销,但爬虫日志可能已经记录了这些Item被“处理”。

*我的数据库表有数千万条记录,执行 `COUNT()` 查询非常慢,有没有什么快速估算的方法?**

答:是的,对于超大规模的表,精确计数代价很高,大多数数据库都提供了快速估算行数的方法,这对于监控来说通常足够了。

- 对于MySQL:可以查询

information_schema数据库中的TABLES表。TABLE_ROWS字段存储了MySQL对表行数的估算值。SELECT TABLE_ROWS FROM information_schema.TABLES WHERE TABLE_SCHEMA = 'your_database_name' AND TABLE_NAME = 'your_table_name';

注意:这个值是一个估算值,特别是在InnoDB引擎中,可能不是非常精确,但查询速度极快。

- 对于PostgreSQL:可以查询系统目录

pg_stat_user_tables,其中的n_live_tup字段提供了当前活跃行数的估算值。SELECT n_live_tup FROM pg_stat_user_tables WHERE schemaname='public' AND relname='your_table_name';

- 对于MongoDB:可以使用

estimatedDocumentCount()方法,它通过读取集合的元数据来返回计数,避免了全表扫描。db.your_collection_name.estimatedDocumentCount()

这些估算方法牺牲了精确性,换来了极高的查询性能,非常适合用于大规模数据场景下的监控仪表盘或定时检查。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复