Scrapy作为Python生态中功能强大且高效的网络爬虫框架,深受开发者喜爱,其工作流程始于创建一个新的项目,这通常通过scrapy startproject <project_name>命令完成,许多初学者甚至有经验的开发者在执行这一步时,都可能遭遇各种报错,导致项目无法顺利启动,本文旨在系统性地剖析导致scrapy 创建项目报错的常见原因,并提供一套清晰、可操作的排错指南,帮助您快速扫清障碍,顺利开启爬虫开发之旅。

追根溯源:常见报错原因分析

当scrapy startproject命令失败时,其背后的原因往往可以归结为以下几大类,理解这些根源是解决问题的第一步。

环境配置问题

这是最普遍的报错来源,Python环境复杂多变,任何细微的错配都可能导致命令无法执行。

- Python版本不兼容:Scrapy有特定的Python版本要求(较新版本的Scrapy可能不再支持Python 3.6或更早版本),如果您的系统Python版本过低或过高,可能会引发依赖包冲突或直接报错。

- pip版本过旧:一个过时的pip可能无法正确解析和安装Scrapy及其复杂的依赖(如Twisted, lxml, pyOpenSSL等)。

- 环境变量PATH配置错误:即使Scrapy已成功安装,如果其脚本路径未被添加到系统的PATH环境变量中,终端将无法识别

scrapy命令,从而报错“command not found”。 - 多Python版本共存:当系统中同时存在Python 2和Python 3,或多个Python 3版本时,很容易出现使用错误的pip或Python解释器来安装或运行Scrapy的情况。

Scrapy安装问题

安装过程本身也可能埋下隐患。

- 依赖包缺失:Scrapy依赖多个C语言库,如

lxml(依赖libxml2和libxslt)和cryptography,在Windows或macOS上,通过wheel包安装通常能自动处理,但在Linux系统上,如果系统缺少对应的开发库(如python3-dev,build-essential,libxml2-dev,libxslt1-dev等),pip在编译这些依赖时会失败。 - 安装不完整或损坏:网络中断、代理问题或强制中断安装过程都可能导致Scrapy安装不完整。

权限与目录问题

- 写入权限不足:如果您尝试在系统保护的目录(如

/usr/local/或C:Program Files)下创建项目,系统会因权限不足而拒绝写入操作。 - 项目名称不规范:Scrapy的项目名称必须遵循Python的模块命名规则(即只能包含字母、数字和下划线,且不能以数字开头),使用包含空格、连字符或其他特殊字符的名称会导致报错。

事半功倍:系统性排错指南

遇到scrapy 创建项目报错时,请不要慌张,按照以下步骤逐一排查,绝大多数问题都能迎刃而解。

第一步:核实并优化Python与pip环境

这是排错的基石,强烈建议始终在虚拟环境中进行Python项目开发,以实现环境隔离,避免冲突。

创建并激活虚拟环境:

# 创建一个名为 scrapy_env 的虚拟环境 python3 -m venv scrapy_env # 激活虚拟环境 # 在 macOS/Linux 上: source scrapy_env/bin/activate # 在 Windows 上: .scrapy_envScriptsactivate

激活后,您的命令提示符前会出现

(scrapy_env)字样,表示已进入隔离环境。

检查版本:

python --version pip --version

确保Python版本符合Scrapy要求,并升级pip到最新版:

pip install --upgrade pip。

第二步:干净彻底地安装Scrapy

在虚拟环境中,重新安装Scrapy,确保其完整性和所有依赖都被正确处理。

卸载旧版本(如果存在):

pip uninstall scrapy重新安装:

pip install scrapy验证安装:

scrapy version

如果此命令成功返回Scrapy的版本号,说明安装和PATH配置基本正确,如果报错“command not found”,但pip show scrapy显示已安装,可能是虚拟环境激活有问题,需重新激活。

对于Linux用户,如果安装过程中出现编译错误,请先安装系统依赖:

# Debian/Ubuntu sudo apt-get install python3-dev build-essential libxml2-dev libxslt1-dev zlib1g-dev libffi-dev libssl-dev # CentOS/RHEL sudo yum install python3-devel gcc libxml2-devel libxslt-devel zlib-devel libffi-devel openssl-devel

然后再运行pip install scrapy。

第三步:检查目录权限与命令语法

- 切换到安全的目录:执行

cd ~进入用户主目录,或任何您有完全读写权限的文件夹,然后再运行创建项目命令。 - 验证项目名称:确保您的项目名称符合规范,下表列出了一些正误示例:

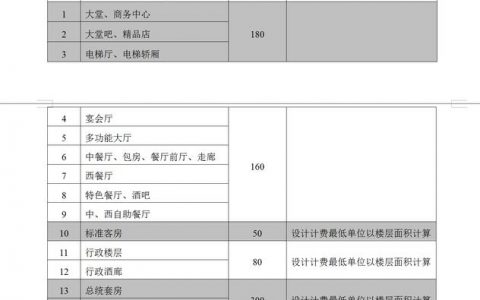

| 合法的项目名称 | 非法的项目名称及原因 |

|---|---|

my_crawler | my-crawler (包含连字符) |

project01 | 01project (以数字开头) |

spider_project | spider project (包含空格) |

scrapy_test | import (使用了Python关键字) |

正确的命令格式应为:scrapy startproject my_spider_project

第四步:网络与特殊情况排查

如果您身处网络受限的环境,可以考虑使用国内镜像源来加速安装并避免连接问题:pip install -i https://pypi.tuna.tsinghua.edu.cn/simple scrapy

相关问答FAQs

A: 这个问题通常意味着Scrapy的可执行文件所在的目录没有被添加到系统的PATH环境变量中,最常见的原因有两个:一是您没有激活安装Scrapy所在的虚拟环境;二是您使用了系统全局的Python/pip进行安装,但由于权限或配置问题,脚本路径未被正确添加。最佳实践是始终在激活的虚拟环境中工作,这能确保您使用的scrapy命令就是当前环境下的那个,如果问题依旧,可以尝试重新激活虚拟环境,或者在虚拟环境中使用python -m scrapy来代替scrapy命令,python -m scrapy startproject myproject。

Q2: 我可以为我的Scrapy项目使用任意名字吗?比如包含中文或特殊字符?

A: 不可以,Scrapy项目名称在底层会被用作Python包(模块)的名称,它必须严格遵循Python模块的命名规则,规则包括:名称只能由字母、数字和下划线(_)组成;不能以数字开头;不能是Python的保留关键字(如class, def, import等);且强烈建议全部使用小写字母,使用中文、空格、连字符()或其他标点符号都会导致创建项目时语法解析失败。我的爬虫或my-spider都是非法的,应改为my_spider或wo_de_pa_chong(不推荐但合法的拼音)。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复