在分布式系统的广阔天地中,消息队列扮演着至关重要的角色,而Apache Kafka无疑是其中的佼佼者,正如任何复杂的系统一样,Kafka在运行过程中也难免会出现各种报错,当用户提及“kkao报错”时,通常指向的就是Kafka相关的错误,理解这些错误的根源,是保障系统稳定性和数据一致性的关键,本文将系统性地剖析Kafka报错的常见原因,并提供一套行之有效的排查思路,帮助开发者与运维人员快速定位并解决问题。

Kafka的报错并非孤立事件,它们往往源于系统栈的某个层面,为了系统地分析,我们可以将这些原因归纳为以下几个主要类别。

网络层面问题

网络是分布式系统的基石,也是最常见的故障来源之一,Kafka集群内部Broker之间、Broker与客户端(生产者/消费者)之间的通信都高度依赖于稳定可靠的网络。

- 连接超时与拒绝:客户端无法连接到Kafka Broker,通常表现为

TimeoutException: Failed to update metadata或Connection refused,这可能是由于防火墙策略阻止了指定端口(默认9092)、Broker服务未启动、或者网络延迟过高导致连接在规定时间内未能建立。 - DNS解析失败:客户端配置了Broker的主机名而非IP地址,但DNS服务器无法正确解析,导致连接失败。

- 网络分区:在极端情况下,网络故障可能导致集群被分割成多个无法互相通信的子集,即“脑裂”现象,这会引发数据不一致、Leader选举失败等一系列严重问题。

Broker(服务器)层面问题

Broker是Kafka集群的核心组件,其自身的健康状况直接决定了整个集群的可用性。

- 磁盘空间耗尽:这是生产环境中最常见的“硬伤”,Kafka将消息持久化存储在磁盘上,当磁盘使用率达到某个阈值(由

log.retention.hours或log.segment.bytes等参数控制)时,Broker会停止接收新消息,甚至可能崩溃,监控磁盘空间是运维的重中之重。 - JVM内存溢出(OOM):Kafka Broker运行在JVM之上,如果分配的堆内存不足,或者存在内存泄漏,就可能触发

OutOfMemoryError,导致Broker进程突然终止,这通常与活跃的分区数、消费者数量以及请求处理负载有关。 - 配置错误:

advertised.listeners是一个极易出错的配置项,如果它配置的地址或端口无法被客户端访问,就会出现“能连接上,但无法获取数据”的诡异现象。num.network.threads、num.io.threads等线程池配置不当,也会在高并发下导致性能瓶颈或请求被拒绝。 - Broker宕机:物理机故障、操作系统崩溃或Kafka进程被异常杀死,都会导致Broker离线,虽然Kafka具备高可用设计,但多个Broker同时宕机会引发分区不可用,甚至数据丢失(如果未配置足够的副本)。

客户端(生产者/消费者)层面问题

客户端的错误往往与代码逻辑和配置紧密相关。

- 序列化/反序列化不匹配:生产者使用的序列化器(Serializer)与消费者使用的反序列化器(Deserializer)不一致,生产者用

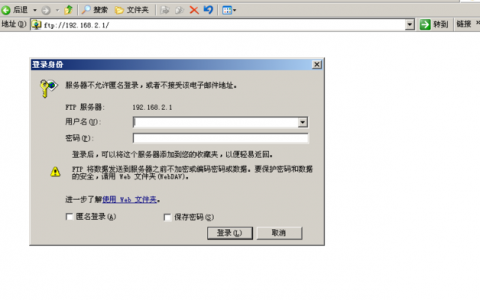

StringSerializer发送字符串,消费者却用ByteArrayDeserializer接收,会导致数据解析失败,抛出SerializationException。 - 认证与授权失败:当集群启用了SASL/SSL等安全机制时,如果客户端提供的凭证(用户名密码、证书等)错误,或者权限不足,将无法连接到Broker或进行读写操作,报错信息中通常会包含

Authentication failed或Authorization failed。 - 版本不兼容:使用了不兼容的Kafka客户端版本与Broker版本,虽然Kafka尽力保持向后兼容,但跨大版本使用时,某些协议或API可能已废弃,从而引发未知错误。

- 消费者偏移量(Offset)问题:常见的

OffsetOutOfRangeException错误,意味着消费者试图读取一个不存在的消息偏移量,这通常发生在消息已被过期清理,或者消费者组提交了一个无效的偏移量之后。

协调服务层面问题

Kafka的集群元数据管理依赖于ZooKeeper(在旧版本中)或KRaft(Kafka Raft,在新版本中)。

- ZooKeeper会话超时:如果Broker与ZooKeeper之间的连接中断或响应过慢,导致会话超时,Broker会将自己从集群中移除,触发重新选举,造成短暂的不可用。

- KRaft控制器故障:在KRaft模式下,Controller节点负责管理整个集群的元数据,如果Controller节点宕机,集群会选举新的Controller,期间元数据操作(如创建主题)会失败。

为了更直观地展示,下表列出了几种典型报错与可能原因的对应关系:

| 错误信息(示例) | 可能原因 | 排查建议 |

|---|---|---|

NetworkException: The server disconnected... | 网络抖动、防火墙、Broker重启 | 检查网络连通性,查看Broker日志,确认客户端重试机制。 |

LeaderNotAvailableException | 分区Leader所在的Broker宕机或正在进行选举 | 检查集群状态,确认对应Broker是否存活,等待选举完成。 |

OutOfMemoryError: Java heap space | Broker JVM堆内存不足 | 增加JVM堆内存大小(KAFKA_HEAP_OPTS),分析内存使用情况。 |

OffsetOutOfRangeException | 消费者偏移量无效,对应消息已被删除 | 重置消费者偏移量(--reset-offsets),或调整消息保留策略。 |

系统化排查方法论

面对纷繁复杂的报错,一个清晰的排查流程至关重要。

- 首先看日志:这是排查任何问题的第一原则,优先查看Kafka Broker的

server.log,它记录了集群内部的所有核心事件,检查客户端(生产者/消费者)的应用日志,里面包含了请求发送、接收以及处理过程中的详细错误信息。 - 使用命令行工具:Kafka自带了一系列强大的命令行工具,使用

kafka-topics.sh --describe查看主题的分区、Leader和副本分布情况;使用kafka-consumer-groups.sh --describe检查消费者组的偏移量和消费延迟。 - 监控关键指标:建立完善的监控体系,实时关注Broker的CPU、内存、磁盘I/O、网络流量等基础指标,以及Kafka特有的指标,如

UnderReplicatedPartitions、IsrShrinksPerSec、RequestQueueSize等,这些指标是预警潜在问题的“哨兵”。 - 隔离与复现:尝试在测试环境中复现问题,如果问题只出现在特定的生产者或消费者上,那么问题很可能出在客户端代码或配置,如果是全局性问题,则更可能是Broker或网络层面的故障。

Kafka的报错原因涉及网络、服务器、客户端和协调服务等多个层面,解决问题的关键在于建立系统化的思维,从宏观到微观,结合日志、工具和监控,逐步缩小问题范围,最终定位根源,通过深入理解这些常见错误及其背后的原理,我们不仅能更高效地处理线上故障,更能从设计之初就构建出更加健壮、可靠的Kafka应用。

相关问答FAQs

Q1: 遇到Kafka报错时,最应该优先检查的是什么?

A1: 优先检查日志,应该首先查看报错客户端的应用日志,了解错误发生的具体上下文和错误堆栈,立即登录到相关的Kafka Broker服务器,检查server.log文件,搜索与该客户端或相关主题的日志记录,Broker日志通常能揭示问题的根源,例如连接被拒绝、请求处理失败或内部错误等,日志是定位问题的最快路径。

Q2: 如何有效预防Kafka在生产环境中出现常见的磁盘和内存问题?

A2: 预防远胜于治疗,针对磁盘问题,必须建立严格的磁盘使用率监控告警,当使用率超过阈值(如75%)时立即通知运维人员,合理配置消息保留策略(retention.ms或retention.bytes),避免无用消息无限堆积,针对内存问题,应根据Broker的分区数、负载和机器配置,合理设置JVM堆内存大小(建议不超过31GB),启用JVM的GC日志监控,定期分析垃圾回收情况,及时发现潜在的性能瓶颈或内存泄漏迹象,对关键指标进行自动化监控和告警,是预防生产事故的核心手段。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复