在构建大数据实时采集管道时,Apache Flume凭借其灵活、可扩展的架构,成为了连接数据源与中央存储的首选工具之一,Hive Sink组件能够将Flume采集的事件数据直接写入Hive表,极大地简化了数据从采集到分析的流程,由于其配置的复杂性和对Hadoop/Hive环境的强依赖性,Flume Hive Sink的配置和运行过程中常常会遇到各种报错,本文旨在系统性地梳理这些常见错误,并提供清晰的排查思路与解决方案,帮助开发者快速定位并解决问题。

配置层面的常见问题

配置错误是导致Hive Sink失败的最主要原因,这些问题通常在Flume Agent启动时或初次尝试写入数据时暴露出来。

Metastore连接失败

这是最基础也是最关键的错误,Hive Sink需要连接到Hive Metastore服务以获取表的元数据信息(如存储位置、分区信息、SerDe等),如果连接失败,整个Sink将无法工作。

- 错误现象: Flume日志中出现

MetaException,Could not connect to metastore,Connection refused等关键词。 - 可能原因:

flume.conf中hive.metastore.uris参数配置错误,例如IP地址、端口号或协议(thrift://)不正确。- Hive Metastore服务未启动或运行不正常。

- 网络问题,Flume Agent所在节点无法访问Metastore服务节点。

- 解决方案:

- 核对并修正

hive.metastore.uris配置,确保其与Hive配置文件(hive-site.xml)中的hive.metastore.uris完全一致。 - 在Metastore服务所在节点,使用

netstat -anp | grep <port>或ps -ef | grep HiveMetaStore检查服务状态。 - 从Flume Agent节点使用

telnet <metastore-ip> <port>命令测试网络连通性。

- 核对并修正

Kerberos认证问题

在启用了Kerberos的安全集群中,任何服务间的交互都需要进行身份认证,Hive Sink作为客户端访问Metastore和HDFS,必须提供有效的凭证。

- 错误现象: 日志中出现

GSS initiate failed,Authentication failed,No valid credentials provided等错误。 - 可能原因:

- 未提供

principal和keytab文件路径。 keytab文件权限不正确(Flume运行用户无读取权限)。principal已过期或配置错误。

- 未提供

- 解决方案:

- 在

flume.conf的Hive Sink配置中,添加hive.metastore.kerberos.principal和hive.metastore.kerberos.keytab。 - 确保

keytab文件路径正确,且Flume运行用户(如flume用户)对其有读权限(chmod 400 <keytab-file>)。 - 使用

klist -k -t <keytab-file>检查keytab文件中的principal是否有效且未过期。

- 在

Hive环境与数据格式问题

当配置正确后,错误往往源于数据本身或Hive表的定义与Flume Sink期望不匹配。

表或分区不存在

Hive Sink需要将数据写入一个已存在的Hive表,如果配置的数据库或表不存在,写入会失败,对于分区表,如果尝试写入的分区不存在且未配置自动创建分区,同样会报错。

- 错误现象:

NoSuchObjectException,Partition not found等。 - 解决方案:

- 在Hive中执行

USE <db_name>; DESCRIBE <table_name>;确保表存在。 - 如果是分区表,确保目标分区已存在,或在Sink配置中设置

hive.create.partitions = true来允许Flume自动创建分区。

- 在Hive中执行

序列化/反序列化(SerDe)不匹配

Hive表定义了特定的SerDe来解析存储在HDFS上的文件,Flume Hive Sink在写入数据时,必须使用与表定义兼容的序列化器,如果Flume发送的数据格式与Hive表期望的SerDe不符,Hive将无法正确读取数据。

- 错误现象: 数据写入成功,但在Hive中查询结果为NULL或出现解析错误。

- 解决方案:

- 确保Flume Sink的序列化配置(如

serializer)与Hive表的ROW FORMAT SERDE一致,如果Hive表使用了OpenCSVSerde,那么Flume应配置为CSV格式输出。 - 检查字段数量和类型是否匹配,Flume Event的Header和Body映射到Hive表的字段,必须保证字段数和类型兼容。

- 确保Flume Sink的序列化配置(如

系统与运行时错误

这类错误通常与HDFS、资源限制或事务处理有关。

HDFS权限问题

Flume Agent的运行用户需要对Hive表对应的HDFS目录有写权限。

- 错误现象:

Permission denied,AccessControlException。 - 解决方案:

- 使用

hdfs dfs -ls /user/hive/warehouse/<db_name>.db/<table_name>查看目录权限。 - 使用

hdfs dfs -chown -R flume:user /user/hive/warehouse/...或hdfs dfs -chmod -R 755 /user/hive/warehouse/...修改目录所有者或权限。

- 使用

事务超时或冲突

Hive Sink使用HDFS的临时文件和重命名机制来保证事务的原子性,如果长时间运行或高并发,可能会出现问题。

- 解决方案:

- 调整

hive.txn.timeout参数(需在Hive端配置)。 - 检查HDFS的健康状况,确保没有DataNode掉线或磁盘满的情况。

- 调整

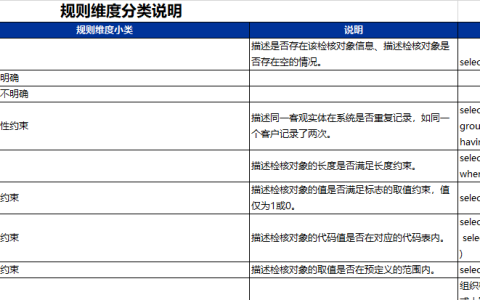

为了更直观地展示,下表小编总结了上述常见错误:

| 错误现象 | 可能原因 | 解决方案 |

|---|---|---|

MetaException, Connection refused | Metastore URI配置错误或服务未启动 | 核对hive.metastore.uris,检查Metastore服务状态和网络 |

GSS initiate failed, Authentication failed | Kerberos认证失败 | 配置正确的principal和keytab,检查文件权限 |

NoSuchObjectException | Hive表或分区不存在 | 提前创建表/分区,或设置hive.create.partitions=true |

| Hive查询结果为NULL或乱码 | SerDe不匹配或数据格式错误 | 确保Flume序列化器与Hive表SerDe一致,检查字段 |

Permission denied | HDFS目录权限不足 | 使用hdfs dfs -chown或-chmod赋予Flume用户写权限 |

排查建议:遇到问题时,首先应仔细阅读Flume Agent的日志文件(flume.log),它通常包含了最详细的错误堆栈信息,遵循“由内到外”的原则:先检查Flume自身配置,再验证与Hive Metastore的连接,最后确认HDFS权限和数据格式,通过这种系统化的排查方法,绝大多数Flume Hive Sink的报错都能被快速定位和解决。

相关问答FAQs

问题1:Flume Hive Sink 和 先用 HDFS Sink 写入,再用 Hive 外部表关联,这两种方案有何优劣?

解答:

- Flume Hive Sink:

- 优点: 集成度高,一步到位实现数据采集与入库;支持事务性(通过

HiveSink的use-local-timestamp和call-timeout等参数),对用户屏蔽了底层文件操作;能自动管理分区。 - 缺点: 配置相对复杂,对Hive环境依赖性强;灵活性稍差,数据格式必须严格匹配Hive表定义;在某些版本或复杂场景下可能存在性能瓶颈或稳定性问题。

- 优点: 集成度高,一步到位实现数据采集与入库;支持事务性(通过

- HDFS Sink + Hive外部表:

- 优点: 架构解耦,Flume只负责将原始数据可靠地写入HDFS,非常稳定灵活;数据可以是任意格式,后续可以用多种工具(Spark, MapReduce, Hive)处理;运维简单,只需维护Flume和HDFS。

- 缺点: 数据写入HDFS后,Hive表无法立即感知到新数据,存在延迟(需要执行

MSCK REPAIR TABLE或添加分区);数据一致性由上层应用保证,Flume本身不提供事务语义。

- 选择建议: 对于需要近乎实时、数据结构稳定、希望简化ETL流程的场景,Flume Hive Sink是不错的选择,对于需要最大灵活性、数据格式多变、或作为数据湖原始数据接入层的场景,HDFS Sink + Hive外部表的方案更为稳健和通用。

问题2:Flume Hive Sink 如何保证数据不丢失不重复(Exactly-Once)?

解答:

Flume Hive Sink本身的设计旨在提供At-Least-Once(至少一次)的交付保证,它通过以下机制工作:

- Channel事务: Flume的Channel(如File Channel)提供事务支持,确保Event从Source到Sink的传递是可靠的。

- HDFS原子操作: Hive Sink将数据写入HDFS的临时文件(如

.tmp前缀),当一批数据(由batchSize控制)成功写入后,才原子性地将临时文件重命名为最终文件名。 - Metastore更新: 成功重命名后,Sink才会去连接Metastore,将新文件或新分区信息更新到Hive的元数据中。

它并不能在所有故障场景下严格实现Exactly-Once,如果在重命名HDFS文件成功后、更新Metastore前Sink进程崩溃,就会导致HDFS上有数据但Hive表“看不见”的情况,当Agent重启后,这部分数据可能会被重复处理。

要实现更接近Exactly-Once的语义,通常需要结合上游幂等性设计和下游处理逻辑:

- 上游幂等性: 确保即使重复处理相同的数据,最终结果也是一致的,在数据中包含唯一ID,下游处理(如Hive聚合)时使用

INSERT OVERWRITE或基于ID去重。 - 使用Flume 1.7+的Hive Sink: 新版本Hive Sink引入了对Hive ACID事务的支持,但这需要Hive表本身是事务表(ORC格式,并启用相应配置),这会带来额外的开销和复杂性。

- 两阶段提交: 在更高级的架构中,可以通过外部协调系统(如ZooKeeper)实现分布式两阶段提交,但这通常超出Flume本身的能力范围。

Flume Hive Sink提供了强大的可靠性保证,但要实现绝对的Exactly-Once,需要在整个数据管道层面进行设计。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复