在日常的数据管理与分析工作中,将Excel中的数据导入数据库是一项极其常见且重要的任务,Excel因其便捷的数据录入和整理功能而被广泛使用,而数据库则以其强大的存储、查询、安全性和并发处理能力成为数据持久化的核心,将两者有效结合,可以实现数据从分散到集中、从静态到动态的转变,本文将系统性地介绍几种主流的导入方法,并探讨其中的关键步骤与最佳实践。

导入前的核心准备工作

无论采用何种技术手段,充分的准备工作都是确保导入过程顺利、数据准确无误的基石,仓促导入往往会导致数据类型错误、乱码、数据丢失或导入失败等问题。

数据清洗与规范化

- 统一数据格式:确保同一列的数据类型一致,日期列应统一为“YYYY-MM-DD”或“YYYY/MM/DD”等标准格式,避免“2025年1月1日”和“2025-01-01”混用,数字列中不应包含文本字符(如“1,000元”中的“元”和逗号)。

- 处理空值:明确空单元格在数据库中的对应含义,是

NULL、空字符串还是默认值0,在Excel中,将所有无内容的单元格统一处理,避免因公式产生的空字符串与真正的空值混淆。 - 移除合并单元格:数据库表的结构是二维的,不支持Excel的合并单元格,导入前必须取消所有合并,并将数据填充到对应的每一行中,否则会导致数据错位。

- 清理冗余信息:删除不必要的空行、空列、小计行、总计行以及表头之外的说明性文字,确保数据区域是一个规整的矩形。

确定目标表结构

- 在数据库中预先创建好用于接收数据的表,表的结构(字段名、数据类型、长度、约束等)必须与Excel中的列一一对应。

- 字段映射:明确Excel的每一列对应数据库表的哪一个字段。

- 数据类型匹配:这是最容易出错的地方,需要仔细规划数据类型的映射关系。

下表是一个常见的数据类型映射参考:

| Excel数据类型 | 常见数据库映射类型 | 说明 |

|---|---|---|

| 常规(文本) | VARCHAR, NVARCHAR, TEXT | 根据文本最大长度选择VARCHAR或TEXT |

| 数字(整数) | INT, BIGINT | 根据数值范围选择 |

| 数字(小数) | DECIMAL, FLOAT, DOUBLE | 金融数据推荐使用DECIMAL以避免精度损失 |

| 日期 | DATE, DATETIME, TIMESTAMP | 根据是否包含时间信息选择 |

| 货币 | DECIMAL, MONEY | 同样,DECIMAL更通用且精确 |

| 布尔值(TRUE/FALSE) | BOOLEAN, BIT, TINYINT(1) | TINYINT(1)用0和1表示,兼容性好 |

主流导入方法详解

根据技术背景和具体场景,可以选择不同的导入方法。

使用数据库管理工具的导入向导(图形界面)

这是最直观、最适合初学者和非专业开发人员的方法,主流的数据库管理系统(DBMS)都提供了功能强大的图形化管理工具。

- SQL Server: 使用 SQL Server Management Studio (SSMS) 的“导入平面文件”或“导入数据”向导。

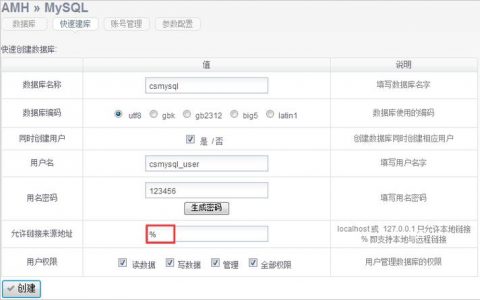

- MySQL: 使用 MySQL Workbench 的“Table Data Import Wizard”。

- PostgreSQL: 使用 pgAdmin 的“Import/Export”功能。

- 通用工具: DBeaver、Navicat 等跨平台数据库管理工具也提供了非常友好的导入界面。

通用操作步骤如下:

- 连接到目标数据库。

- 在数据库对象浏览器中找到目标表,右键点击,选择“导入数据”或类似选项。

- 选择数据源为“Excel”或“CSV”(部分工具要求先将Excel另存为CSV格式)。

- 配置源文件路径、编码格式(强烈建议使用UTF-8以避免中文乱码)。

- 在“映射”或“列”配置界面,手动或自动匹配Excel的列与数据库表的字段。

- 预览数据,确保映射正确无误。

- 点击“开始”或“执行”,完成导入。

使用SQL语句直接导入(命令行)

对于习惯使用命令行的用户或需要将导入过程脚本化的场景,直接使用SQL语句是更高效的选择,这需要先将Excel文件另存为CSV(逗号分隔值)格式,因为绝大多数数据库直接支持CSV的批量导入。

以MySQL为例,可以使用 LOAD DATA INFILE 语句:

LOAD DATA LOCAL INFILE 'C:/path/to/your/data.csv' INTO TABLE your_target_table FIELDS TERMINATED BY ',' -- 指定字段分隔符为逗号 OPTIONALLY ENCLOSED BY '"' -- 字段可用双引号包围 LINES TERMINATED BY 'n' -- 指定行分隔符为换行符 IGNORE 1 ROWS -- 忽略CSV文件的第一行(通常是表头) (column1, column2, column3, ...); -- 按顺序列出要插入数据的列名

关键点解释:

LOCAL INFILE表示从客户端本地读取文件,若省略LOCAL,则文件必须在服务器上,且需要相应的权限。FIELDS TERMINATED BY必须与CSV文件的实际分隔符一致。IGNORE 1 ROWS非常实用,可以跳过Excel的标题行。- SQL Server 对应的命令是

BULK INSERT,PostgreSQL 是COPY,语法略有不同但核心思想一致。

通过编程语言脚本导入(自动化与定制化)

当需要处理复杂的数据清洗、转换逻辑,或需要将此操作集成到自动化工作流中时,使用编程语言(如Python、Java、C#)是最佳选择,Python因其丰富的数据处理库而成为首选。

使用Python的pandas和sqlalchemy库的示例:

import pandas as pd

from sqlalchemy import create_engine

# 1. 读取Excel文件

# 可以指定sheet_name, header行等参数

df = pd.read_excel('your_data_file.xlsx', sheet_name='Sheet1')

# 2. (可选) 数据清洗与转换

# 将日期列转换为标准格式

df['date_column'] = pd.to_datetime(df['date_column']).dt.strftime('%Y-%m-%d')

# 填充空值

df.fillna('', inplace=True)

# 3. 创建数据库连接

# 使用SQLAlchemy创建引擎,支持多种数据库

# 格式: '数据库类型+驱动://用户名:密码@主机:端口/数据库名'

engine = create_engine('mysql+pymysql://user:password@host:port/db_name')

# 4. 将DataFrame数据写入数据库

# name: 目标表名

# con: 数据库引擎

# if_exists: 'fail'(表存在则失败), 'replace'(替换表), 'append'(追加数据)

# index: 是否将DataFrame的索引作为一列写入

df.to_sql(name='your_target_table', con=engine, if_exists='append', index=False)

print("数据导入成功!") 此方法灵活性极高,可以在导入前利用pandas强大的功能进行任意复杂的数据处理。

小编总结与建议

选择哪种方法取决于具体需求:

- 一次性、少量数据导入:优先考虑图形界面工具,简单直观。

- 定期、重复性导入:使用SQL脚本或编程语言脚本,实现自动化。

- 需要复杂数据预处理:必须使用编程语言,如Python,在导入前进行彻底的数据清洗和转换。

无论采用何种方法,核心都在于“准备”,干净、规范的源数据和结构匹配的目标表是成功导入的先决条件,在实际操作中,建议先用少量数据进行测试,确认无误后再处理全量数据,并做好数据库的备份工作,以防万一。

相关问答FAQs

导入数据时提示“数据类型转换失败”或“字符串截断”该怎么办?

解答: 这是数据导入中最常见的错误之一。

- 数据类型不匹配:检查报错行对应列的数据,你试图将一个包含字母的文本(如“ID-123”)导入数据库的

INT(整数)类型字段中,解决方案是修改数据库表该字段的数据类型为VARCHAR,或者在Excel中清洗掉不符合格式的数据。 - 数据长度超限:你试图将一个长度为50个字符的字符串导入数据库中定义为

VARCHAR(30)的字段,解决方案是在数据库中增加该字段的长度,或者在Excel中缩短数据内容。 - 特殊格式问题:日期格式不标准、数字中包含千分位逗号或货币符号等,解决方案是在Excel中通过“分列”功能或公式统一数据格式,确保其纯净性。

我的Excel文件很大(几十万行),使用图形界面导入非常慢甚至卡死,有什么优化建议?

解答: 对于大数据量,图形界面工具往往因为内存占用和逐行处理而效率低下。

- 首选SQL命令或脚本:放弃图形界面,直接使用

LOAD DATA INFILE(MySQL)或BULK INSERT(SQL Server)等命令,这些命令是数据库原生优化的,导入速度极快。 - 转换为CSV格式:无论使用SQL命令还是编程脚本,都先将Excel另存为CSV格式,CSV是纯文本,读写开销远小于二进制的Excel文件。

- 分批导入:如果单次导入仍然有问题,可以考虑将大的CSV文件分割成多个小文件,然后循环执行导入命令或脚本,在编程脚本中,可以设置

chunksize参数进行分块读取和写入。 - 暂停索引和约束:在导入大量数据前,可以临时禁用目标表的索引和外键约束,待数据全部导入后再重新构建,这能大幅减少导入过程中数据库维护索引的开销。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复