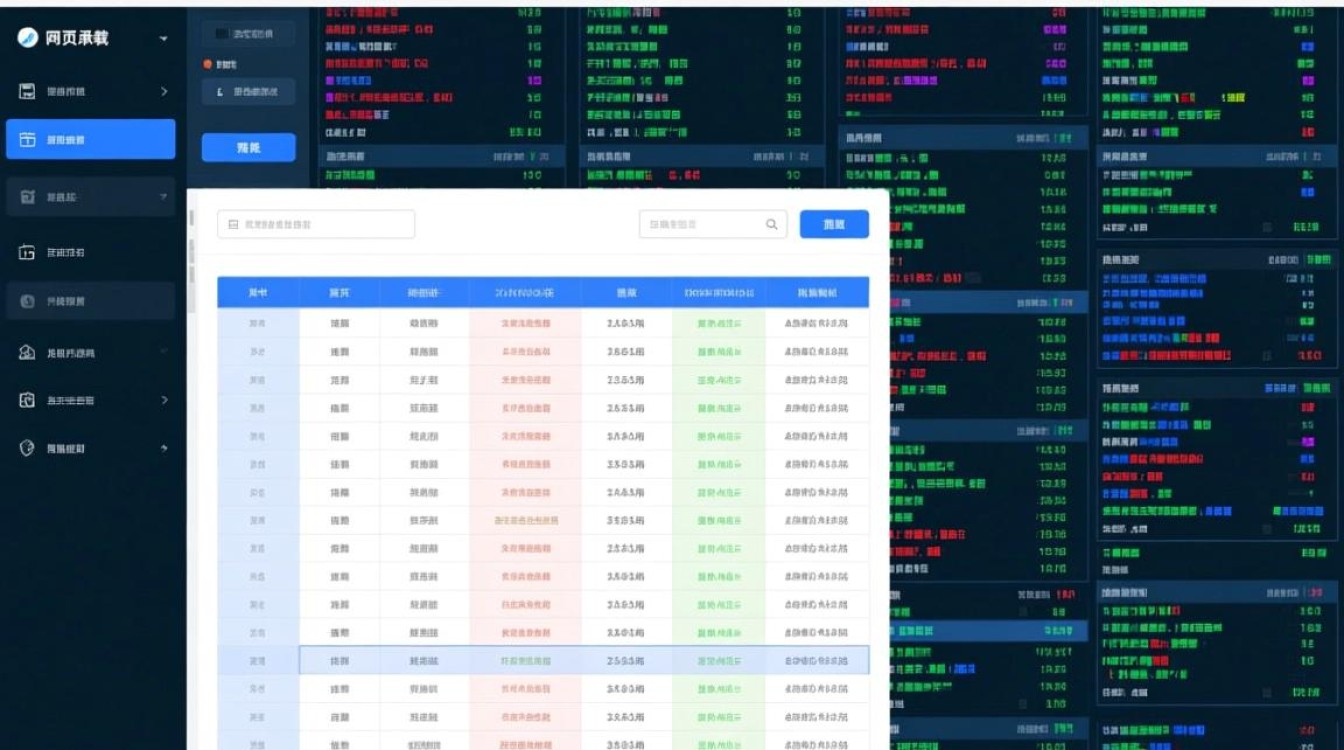

在信息爆炸的时代,网页承载着海量的结构化数据,其中表格是最常见的形式,无论是进行市场分析、学术研究还是构建个人数据库,我们经常需要将这些网页表格数据提取出来,这个过程并非总是简单的“复制-粘贴”,根据数据量、更新频率和技术背景的不同,可以选择多种方法,从简单手动到全自动脚本,各有优劣。

手动复制粘贴:最直接的方法

这是最直观、无需任何技术背景的方法,直接用鼠标选中网页上的表格内容,复制(Ctrl+C),然后粘贴(Ctrl+V)到Excel、Google Sheets或Word等应用程序中。

- 优点:操作简单,零学习成本,适用于一次性、小规模的数据获取。

- 缺点:

- 格式错乱:网页的CSS样式与目标软件的格式不兼容,经常导致合并单元格、边框丢失等问题,需要大量手动调整。

- 效率低下:对于多页或大型表格,操作繁琐且耗时。

- 易出错:手动选择时容易漏选或多选行/列,导致数据不准确。

利用浏览器开发者工具:更精准的选择

当复制粘贴出现格式问题时,浏览器内置的开发者工具(通常按F12键打开)提供了一个更可靠的解决方案。

- 在目标表格上右键点击,选择“检查”或“审查元素”,浏览器会自动定位到表格对应的HTML代码(通常是

<table>标签)。 - 在HTML代码面板中,找到整个

<table>元素,右键点击它。 - 在弹出的菜单中选择“复制” -> “复制元素”或“复制outerHTML”。

- 将复制得到的HTML代码粘贴到一个文本编辑器中,保存为

.html文件,然后用Excel直接打开这个文件,Excel通常能很好地解析HTML表格结构,保留原始的行列关系。

- 优点:能获取更纯净的表格结构,有效避免大部分格式问题。

- 缺点:仍需手动操作,不适合批量或重复性任务。

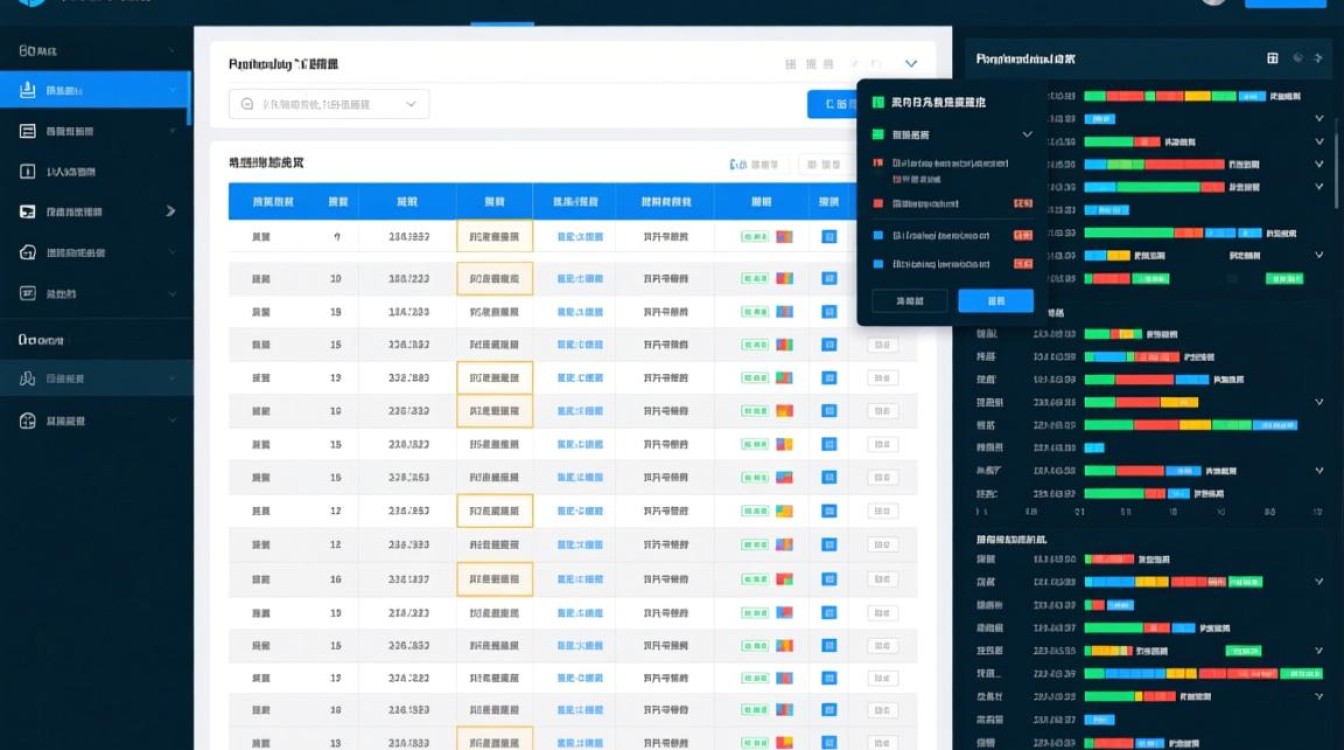

借助浏览器扩展程序:效率与便捷的平衡

对于需要频繁从网页抓取表格的用户,安装专门的浏览器扩展是极佳的选择,Table Capture”、“Web Scraper”等扩展程序。

Table Capture:这类工具能自动识别页面上的所有表格,提供一个列表让你选择,你可以一键将表格数据导出为CSV格式,该格式能被Excel、数据库等几乎所有数据处理工具完美兼容。

Web Scraper:功能更强大,它允许你通过点击页面元素来创建抓取规则(爬取流程),不仅能抓取表格,还能抓取链接、文本等,并支持定时抓取和数据导出。

优点:极大提升效率,操作相对简单,无需编程知识,是手动方法和编程方法之间的完美桥梁。

缺点:功能强大的扩展可能需要一定的学习成本,且对于结构异常复杂或动态加载的表格,可能无法完美处理。

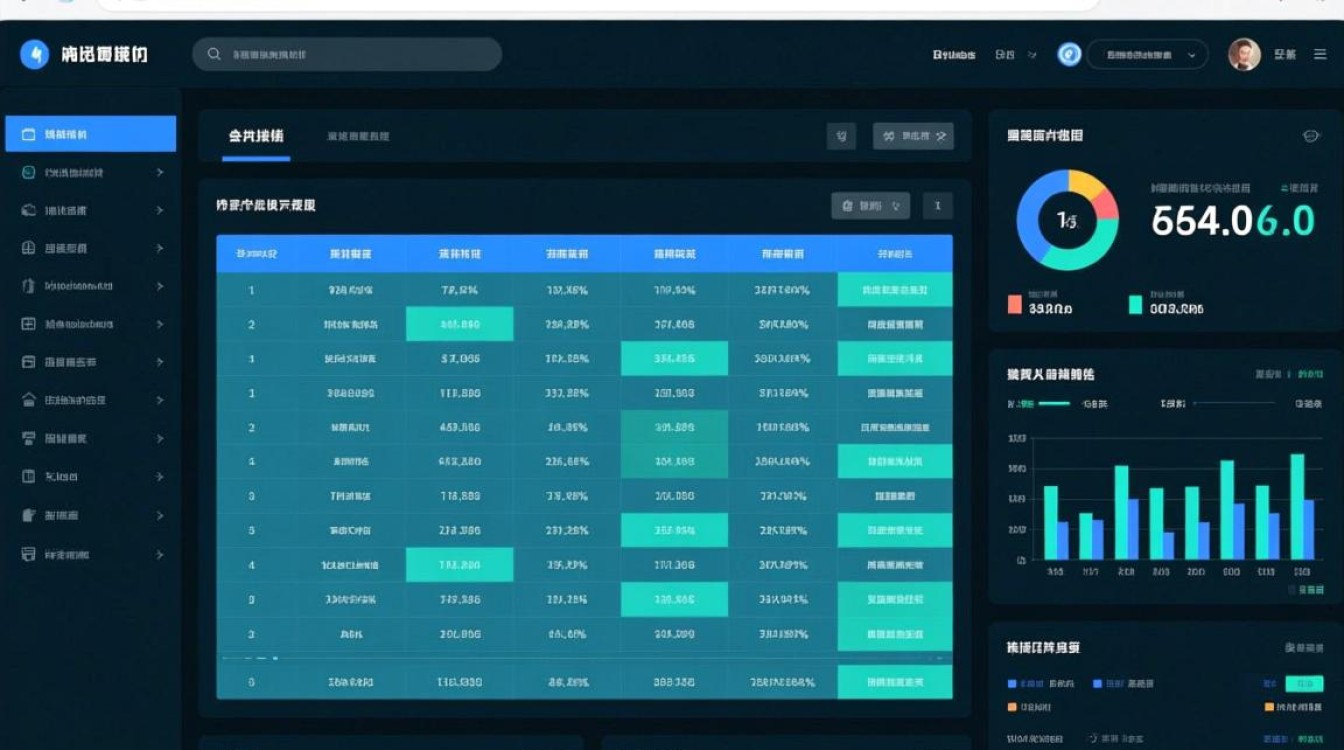

编写脚本自动化:终极解决方案

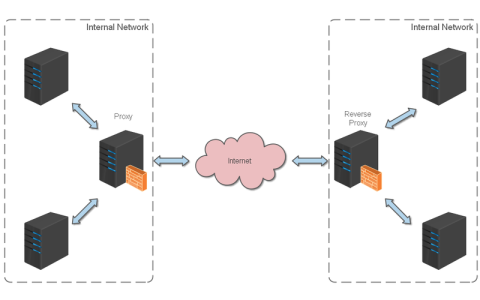

当面临大规模、高频率、需要整合到数据库中的数据需求时,编写自动化脚本是唯一可靠的选择,Python是完成此任务最流行的语言,其强大的生态系统让整个过程变得高效。

核心流程如下:

- 获取网页内容:使用

Requests库向目标URL发送HTTP请求,获取网页的HTML源码。 - 解析HTML:使用

Beautiful Soup或lxml库解析HTML代码,像操作DOM树一样精准定位到<table>标签及其内部的<tr>(行)和<td>(单元格)。 - 数据清洗与结构化:将提取的文本数据清理干净(如去除多余空格、换行符),然后使用

Pandas库将其转换成DataFrame对象,DataFrame是一个二维表格结构,非常适合后续处理。 - 存入数据库:

Pandas提供了to_sql()方法,可以非常方便地将DataFrame中的数据直接写入SQLite、MySQL、PostgreSQL等任何SQL数据库中,实现从网页到数据库的无缝对接。

- 优点:完全自动化,可扩展性强,能处理动态内容(结合Selenium),数据准确性高,可直接与数据库集成。

- 缺点:需要编程知识,前期开发成本较高。

| 方法 | 易用性 | 可扩展性 | 技术要求 | 数据准确性 |

|---|---|---|---|---|

| 手动复制粘贴 | 极高 | 极低 | 无 | 低 |

| 开发者工具 | 中等 | 低 | 低 | 中等 |

| 浏览器扩展 | 高 | 中等 | 低 | 高 |

| 编写脚本 | 低 | 极高 | 高 | 极高 |

相关问答FAQs

为什么我直接从网页复制表格到Excel,格式总是错乱,特别是合并单元格?

解答:这是因为网页使用HTML和CSS来定义表格的视觉样式,而Excel有其自己的单元格合并和格式化逻辑,当你直接粘贴时,Excel试图将网页的样式转换为自己的格式,这个过程并不完美,常常导致合并单元格信息丢失或错位,更可靠的方法是使用浏览器开发者工具复制表格的HTML代码,然后用Excel打开这个HTML文件,这样Excel就能根据原始的<table>结构来重建表格,大大减少格式错误。

如果需要每天自动抓取一个网页的更新数据,但我不懂编程,有什么好办法吗?

解答:对于没有编程背景但需要自动化任务的用户,最佳选择是使用无代码(No-Code)或低代码的网页抓取工具,除了前面提到的浏览器扩展“Web Scraper”(它支持设置定时抓取),还有一些更专业的云端平台,如Octoparse、Parsehub等,这些工具提供可视化的点击式界面,你只需在浏览器中模拟操作,告诉它要抓取哪些数据,然后就可以在平台上设置定时任务(例如每天执行一次),平台会自动完成抓取并将数据通过邮件、API或下载链接发送给你,无需编写一行代码。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复