GPU服务器技术中,故障自诊断是一个至关重要的环节,特别是在维护高性能计算环境时,下面将详细探讨GPU实例故障自诊断的各个方面:

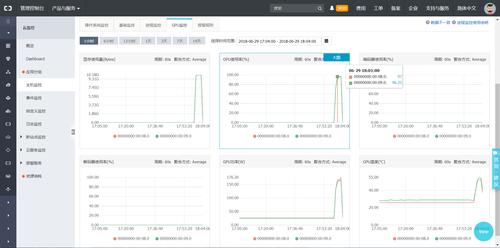

1、监控与报警系统

CES监控事件通知:当GPU服务器出现异常时,已安装的GPU监控CES Agent会产生事件通知,这有助于及时发现问题以避免进一步的损失。

云监控功能:阿里云等云服务提供商的云监控已原生支持GPU实例,可以对GPU卡状态或驱动状态进行全方位诊断,帮助及时发现和解决常见问题。

2、故障信息收集

GPU故障信息收集脚本:可使用专门的脚本进行一键收集故障信息,或通过命令行手动收集,为后续的故障分类和处理提供必要的信息。

ECS管理控制台配置:ECS管理控制台支持配置GPU设备健康检查功能,便于自行诊断当前实例的GPU卡或驱动是否存在异常。

3、GPU实例故障处理流程

初步排查:确认故障现象是否为GPU相关,并尝试了解故障发生的环境和条件。

信息整理:收集故障发生时的系统日志、GPU状态信息及应用日志,以便进行深入分析。

故障诊断:根据收集的信息,判断故障类型,如显卡故障或是驱动问题,并进行针对性处理。

4、故障分类与诊断

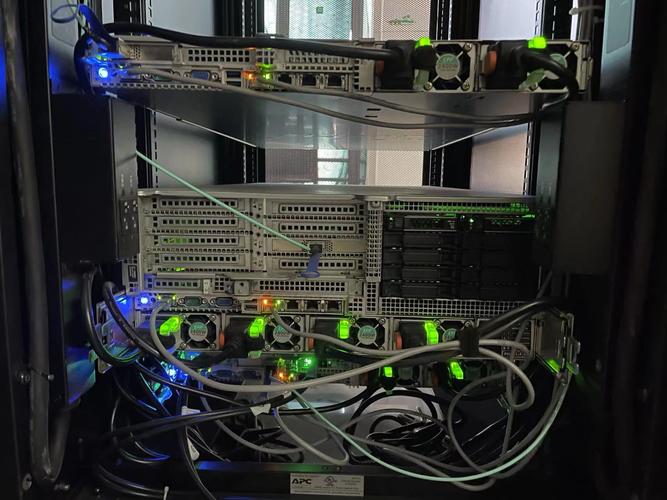

显卡故障处理方法:对于显卡本身的故障,需要按照显卡诊断的方法进行处理,可能涉及更换硬件或更新固件等操作。

非硬件故障自恢复:对于非硬件故障,可以尝试软件层面的恢复操作,例如重启服务或重置驱动状态。

5、自动监测与报警

自定义监控:可以通过云监控的自定义监控功能来监测特定的GPU状态,并设置报警策略。

上报自定义事件:利用OpenApi PutCustomEvent进行自定义事件的上报,当检测到GPU卡异常时,可以自动触发报警,及时通知相关人员。

6、GPU实例小概率场景处理

显存校验失败场景的处理:在小概率场景中,GPU卡因显存校验失败而暂时不可用时,需要能够快速隔离、迁移业务,以减少对业务系统的影响。

高可用标准下的自动监测:对于业务高可用标准高、服务器数量大的情况,自动监测和报警尤为重要,以确保业务的连续性。

在了解上述内容后,还可以关注以下几个方面:

在面对GPU实例故障时,要确保监控系统的有效性和及时性,监控工具应能实时反映GPU的状态,并在检测到异常时立即通知。

建议定期对GPU实例进行健康检查和维护,包括软件和硬件层面的检查,以及对操作系统和驱动程序的更新。

对于一些复杂的故障,可能需要专业的技术支持团队介入分析和处理,建立与供应商的良好沟通渠道也是保证故障快速响应的关键因素。

GPU服务器技术的故障自诊断是一个多方面的过程,涉及监控、信息收集、故障处理、分类诊断以及自动监测与报警等方面,通过对这些方面的细致梳理和实践,可以有效提升GPU实例的可靠性和稳定性,保障业务运行的连续性,对于运维人员而言,熟练掌握这些自诊断技术是保持GPU服务器高效运行的必要技能。

【版权声明】:本站所有内容均来自网络,若无意侵犯到您的权利,请及时与我们联系将尽快删除相关内容!

发表回复